A ética é um elemento central no desenvolvimento de novos artefatos científico-tecnológicos, para garantir que as máquinas possam coexistir com o ser humano, argumenta o teólogo

Enquanto o desenvolvimento técnico-científico avança através da inteligência artificial e promete um mundo completamente novo, forjando uma cosmologia e uma antropologia distintas, a capacidade humana de se interrogar sobre si mesma e sobre a realidade nos conduz a recolocar velhas perguntas para compreendermos os efeitos da transformação digital em curso.

Neste momento histórico em que o ser humano se depara com um novo modelo explicativo da realidade, em que as novas tecnologias podem mudar radicalmente o modo como nos compreendemos e como compreendemos o universo, questões filosóficas, teológicas e científicas que marcaram a história da humanidade precisam ser refeitas. "Qual é a verdade, o que é a epistemologia, e como podemos manter as coisas seguindo adiante de uma forma propositiva?", são perguntas para as quais temos que buscar respostas, diz Paolo Benanti, professor da Pontifícia Universidade Gregoriana, na Itália.

Para respondê-las, o pesquisador italiano sugere "pegar a questão no cerne: deveríamos reconhecer que nós sentimos um desconforto com relação ao que a transformação digital está produzindo para nós? Vivemos um momento de desconforto? Isso é verdade? Para responder a essas perguntas, precisamos responder a outras: Não é demasiado pretender que a tecnologia está mudando radicalmente o mundo em que vivemos e que ela tem o poder de transformar tão profundamente a forma como entendemos os seres humanos e a sociedade?"

Pesquisador de temas relacionados à ética, bioética e ética da tecnologia, Benanti participou do XIX Simpósio Internacional IHU Homo Digitalis. A escalada da algoritmização da vida em fevereiro deste ano, promovido pelo Instituto Humanitas Unisinos - IHU em seu Canal no YouTube.

Na palestra intitulada "A Algoritmização da vida no contexto da Covid-19. Implicações éticas e teológicas", ele explicou como os artefatos técnicos modificam a nossa compreensão da realidade e refletiu sobre os efeitos da inteligência artificial, dos algoritmos e dos dados neste processo. A mudança tecnológica em curso, sugere, precisa incluir a ética em seus projetos, como uma forma de garantir que o avanço tecnológico seja acompanhado do desenvolvimento da sociedade que almejamos. "A ética não é apenas uma forma de questionar a tecnologia, mas, sim, uma perspectiva que nos permite projetar a tecnologia de uma forma que seja muito mais compatível com a sociedade humana e com as ações da coletividade e da nação que gostaríamos de projetar".

A seguir, reproduzimos a apresentação de Benanti em forma de entrevista, a partir das próprias questões formuladas e expostas pelo pesquisador.

Paolo Benanti (Foto: reprodução Canal do YouTube)

Paolo Benanti é doutor em Teologia Moral pela Pontifícia Universidade Gregoriana. Sua tese, intitulada “O Ciborgue. Corpo e corporeidade na era pós-humana” conquistou o Prêmio Belarmino - Vedovato. Atualmente, leciona na Pontifícia Universidade Gregoriana, no Instituto Teológico de Assis e no Pontifício Colégio Leoniano de Anagni. Ele fez parte da Força-Tarefa de Inteligência Artificial para auxiliar a Agência para a Itália Digital. No final de 2018 foi selecionado pelo Ministério do Desenvolvimento Econômico italiano como membro do grupo de trinta especialistas que a nível nacional têm como missão desenvolver a estratégia nacional de inteligência artificial e a estratégia nacional de tecnologias.

Confira a entrevista.

IHU On-Line - O que significa falar em ética da tecnologia? Como abordar a era digital no sentido da ética da tecnologia? E o que significa ser humano em uma condição tecno-humana?

Paolo Benanti - Temos que enfrentar a nossa identidade e nós, como espécie, somos realmente singulares entre os outros mamíferos e entre outras espécies vivas na superfície terrestre. Quando observamos o que fizemos nos últimos milhares de anos, percebemos que isso é singular: vivemos na superfície da terra, mudando-a na forma como ela nos é dada, cruzando regiões e continentes em toda a latitude do planeta. Isso é singular, especialmente se olharmos o que aconteceu quando um grande mamute do norte da Europa quis ir para o sul da África. Ele tinha que se transformar para conseguir viver num ambiente totalmente árido. Pelo que os antropólogos nos dizem, os seres humanos foram do sul da África para todas as latitudes e longitudes. E quando chegaram ao norte da Europa [para se adaptarem à nova condição], se vestiram com a pele dos mamutes. Então, os seres humanos, ao invés de mudarem a sua capacidade – seu DNA e carga genética –, mudam o meio ambiente através da tecnologia.

Um golfinho, que nada como golfinho, pode fazer isso porque tem em seu DNA esta capacidade. Nós, seres humanos, aprendemos a ler, aprendemos a trabalhar com metais e a codificar um computador não através do nosso DNA, mas por meio de outra tecnologia, como um livro eletrônico ou uma universidade, que também é uma tecnologia. Então, a tecnologia não é apenas uma ferramenta. É uma forma que nos mostra simplesmente o que significa ser humano; é uma forma de entender que a condição humana é uma condição tecno-humana.

IHU On-Line - O que significa dizer que nós, seres humanos, construímos o mundo digital e não estamos mais nos movimentando para outros continentes como fazíamos antes, mas, ao invés disso, descobrimos um outro continente, que é o continente digital? Isso significa que gostaríamos de colonizar, de moldar e usar esse continente digital para colocar a próxima geração na história da humanidade?

Paolo Benanti - Vou tentar questionar a tecnologia na perspectiva da ética da tecnologia para entender esse tipo de perspectiva em particular. Para isso, gostaria de voltar a alguns exemplos expostos no artigo [Do Artifacts Have Politics?] de um famoso especialista em tecnologia, o filósofo americano Langdon Winner. Ele escreveu esse texto na década de 1980, no qual dá o seguinte exemplo: se vocês olharem para uma ponte de concreto, que está sobre uma rodovia que permite que as pessoas de Nova York vão de Long Island Roach para Jones Beach, vocês perceberão que as pessoas geralmente veem apenas uma ponte e um viaduto sobre uma rodovia. Provavelmente há várias pontes e viadutos assim aqui no Brasil também.

Mas se formos um pouco mais a fundo na história dessa ponte, podemos descobrir que por trás dela há um político famoso chamado Robert Moses, que era um dos construtores mais ativos do mercado imobiliário da primeira metade do século XX. Ele tinha ideias políticas muito específicas e uma delas era estratificar a sociedade, de modo que os pobres estivessem com os pobres e a classe média com a classe média. Essa ponte foi construída um pouco mais baixa do que uma ponte padrão porque, dessa forma, ela não permitiria que nenhum transporte público pudesse atravessá-la. Somente pessoas que tinham carro poderiam atravessar essa ponte. Na última frase do artigo, Winner diz: “Temos que reconhecer que todo artefato tecnológico é um deslocamento de poder”. Ou seja, toda vez que você vê alguma coisa construída em concreto, em aço ou, no mundo digital, um algoritmo, você está vendo um deslocamento de poder, isto é, uma coisa simples que é capaz de moldar a sociedade, mudar as relações, e permitir que alguém tenha algum direito ou negar que alguém tenha algum direito. A perspectiva da ética da tecnologia no mundo digital é simplesmente abrir essa caixa-preta do algoritmo e das ferramentas digitais para permitir que as pessoas vejam que tipo de deslocamento de poder existe ali dentro, ou seja, quem está controlando quem.

Isso é realmente simples de entender: vocês podem estar conectados comigo pela internet, mas para fazer isso, vocês precisam ter uma senha e login e devem ser autorizados pelo algoritmo para estar participando comigo desta palestra. O que isso significa? Que o algoritmo, assim como a ponte na década de 1970, é um deslocamento de poder.

Neste mesmo artigo, Winner apresenta outro exemplo. Em 1977, na Universidade da Califórnia, em Los Angeles, foi desenvolvida uma colheitadeira automática para tomates. Até 1977, os tomates eram colhidos à mão por trabalhadores sazonais, geralmente mexicanos que cruzavam a fronteira para trabalhar na época da colheita do tomate e depois retornavam para o México. O desenvolvimento dessa máquina simplesmente tornou o trabalho humano inútil. Em 1977, na Califórnia, havia mais de três mil produtores de tomates. Esse tipo de máquina, que permitiu que o produtor economizasse uma grande quantidade de dinheiro, porque não tinha que pagar ninguém para colher tomates, teve, em contrapartida, um alto preço: custava cem mil dólares em 1970. E não eram todos os produtores que conseguiam pagar esse valor.

Em 1982, quando Winner escreveu esse artigo, na Califórnia existiam apenas alguns produtores, então, a inovação tecnológica produziu duas coisas. A primeira delas foi a concentração do mercado, porque a inovação vem com um alto preço e quem não puder pagar por essa inovação, vai sair do mercado. Então, não se trata apenas de um deslocamento de poder, mas também um fator [social] no sentido de que quem é mais rico e puder investir mais dinheiro, também poderá ganhar a batalha do mercado. Ou seja, a inovação tecnológica tem um efeito secundário: descobrimos que para trabalhar melhor o tomate, tínhamos que selecionar que espécies de tomates poderiam resistir melhor à compressão mecânica da colheitadeira, e descobrimos também que esse tipo de tomate é menos saboroso que os originais [anteriores]. Então, a qualidade do produto, dentro do processo de inovação, mudou para sempre.

O artigo foi escrito quarenta anos atrás, antes da inovação digital. Mas vejam que isso se aplica à inovação digital dos nossos dias. Vejam o que aconteceu: a enorme plataforma, as redes sociais e outras plataformas, simplesmente são um alto investimento. Se vocês olharem o mercado jornalístico, verão que somente as grandes plataformas estão ganhando o mercado de notícias no globo. A grande maioria das pessoas no mundo está lendo notícias não mais no jornal impresso ou ouvindo o noticiário pelo rádio ou o assistindo pela TV, mas [consome informação] através do Facebook e das redes sociais. O que ocorre? É que as notícias precisam ser passíveis de serem lidas pela máquina e isso mudou para sempre. Através do exemplo da ponte em Nova York e da colheitadeira de tomates na Califórnia, podemos ver qual é o tipo de perspectiva que a ética da tecnologia gera para nós.

IHU On-Line - O que significa analisar o desenvolvimento tecnológico a partir da perspectiva da ética da tecnologia?

Paolo Benanti - Significa, por exemplo, observarmos o que significa uma tecnologia, como um imóvel, para projetarmos uma sociedade onde podemos ter um espaço que não é apenas uma zona comercial, como o Central Park, em Nova York. O que gostaríamos de sugerir é que a ética tem que estar [inclusa] já no projeto, porque mais tarde será tarde demais. Se não tivessem projetado o Central Park quando Nova York foi construída, teria sido tarde para criar um parque depois [que a cidade estivesse totalmente ocupada], porque a prefeitura não iria conseguir pagar o preço do terreno para construir o Central Park. Então, a ética não é apenas uma forma de questionar a tecnologia, mas, sim, uma perspectiva que nos permite projetar a tecnologia de uma forma que seja muito mais compatível com a sociedade humana e com as ações da coletividade e da nação que gostaríamos de projetar.

Essa perspectiva da ética da tecnologia precisa ser oferecida ao estudo da inteligência artificial e da tecnologia. A inteligência artificial e a tecnologia não se baseiam, como ocorria com a tecnologia de imóveis, em um projeto industrial, ou seja, não se baseiam no aço, por exemplo. Essa nova tecnologia se baseia num novo tipo de coisa: no que chamamos de dados. Então, quem tem os dados é quem controla a inovação da tecnologia digital. Quando olhamos a tecnologia digital, estamos buscando alguma coisa que não funciona sobre o concreto, o aço, e não precisa de uma energia como o petróleo para funcionar, mas se baseia em dados e num algoritmo para trabalhar com esse tipo de dados.

IHU On-Line - Como criticar ou questionar a tecnologia digital com a qual nos deparamos?

Paolo Benanti - Primeiro, temos que reconhecer a perspectiva da ética da tecnologia que nos força a fazer alguma coisa que realmente está próxima a Galileu. Quando Galileu descobriu a nova constituição do universo, ele apresentou seus resultados à comunidade, ao poder político, aos cientistas e aos filósofos. Eles não acreditaram no que Galileu estava tentando dizer através da tecnologia que ele usava, que era o telescópio. Mas Galileu costumava dizer apenas uma coisa às pessoas que apresentavam objeções à transformação que estava sendo produzida na sociedade: olhem o que estou mostrando; vocês têm que olhar o que esta transformação digital está nos mostrando para questionar a transformação digital, para ter as categorias para moldar a melhor inovação, a qual possa ser compatível com a sociedade que gostaríamos de construir.

Vamos pegar a questão no cerne: deveríamos reconhecer que nós sentimos um desconforto com relação ao que a transformação digital está produzindo para nós? Vivemos um momento de desconforto? Isso é verdade? Para responder a essas perguntas, precisamos responder a outras: o digital não é muito menos transformador do que aquilo que estamos sugerindo para vocês? Não é demasiado pretender que a tecnologia está mudando radicalmente o mundo em que vivemos e que ela tem o poder de transformar tão profundamente a forma como entendemos os seres humanos e a sociedade?

Para responder a essas perguntas, eu gostaria de retomar a história de outra tecnologia. No século XVI, as lentes produziam uma transformação análoga. Então, sim, a tecnologia tem o poder de transformar profundamente a forma como entendemos a nós mesmos e a realidade. Que tipo de transformação foi produzida pela lente? Uma foi a transformação produzida por um artefato, o telescópio, que usava lentes. Com o telescópio, nós pudemos estudar as estrelas, os planetas e também o cosmos. Então, passamos a estudar a realidade infinitamente grande do universo. E o que descobrimos? Descobrimos que não éramos mais o centro do universo. Descobrimos que éramos um dos planetas de um sistema solar, de um sistema de uma galáxia, que é um sistema entre os milhares de galáxias que existem no universo. Esse ponto foi a primeira ferida ao nosso narcisismo, porque até então pensávamos sermos nós o centro do universo, mas descobrimos que éramos apenas uma parte lateral do universo. Então, a tecnologia pode mudar a cosmologia, a forma como entendemos a realidade.

Mas as lentes produziram também outro artefato tecnológico, um microscópio, através do qual pudemos estudar a pequena infinitamente grande parte dos seres – e descobrimos coisas únicas. Nós achávamos que éramos uma coisa única, mas descobrimos, com grande surpresa, que somos feitos de bilhões de partes vivas que chamamos de células. Então, basicamente, com uma lente, desenvolvemos dois artefatos tecnológicos: microscópio e telescópio, que mudaram para sempre a forma como entendemos o universo e a nós mesmos.

Numa perspectiva filosófica, a tecnologia pode mudar a cosmologia e a antropologia. E hoje, não se trata mais de uma questão de lentes, não é uma questão de grande infinito ou pequeno infinito, nem de telescópio nem de microscópio, mas outra tecnologia: o computador que trabalha com dados está produzindo as mesmas mudanças através de uma outra categoria, que é a complexidade. Nós, seres humanos, desenvolvemos uma outra ferramenta que é o computador que pega todos os dados e nos permite encontrar uma correlação entre os dados, e essa correlação está mudando a forma como se pode descrever e entender o universo e a forma como descrevemos e entendemos a nós mesmos.

Vou dar dois exemplos. Se alguém começa a estudar astrofísica neste momento, vai estudar a quantidade de dados que a radiotelescopia está adquirindo sobre o universo e aí vai tentar analisar e colocar os dados no computador para encontrar algum tipo de algoritmo que possa descrever como esses dados se juntam. Então, o computador está mudando o jogo com relação à forma como nós entendemos o universo, está mudando a cosmologia.

Se alguém começar a estudar neurociência, vai descobrir que estamos adquirindo dados do cérebro mapeando como os neurônios estão disparando dentro do cérebro. Quando falamos que estamos tentando explicar a função da nossa mente através de uma correlação complexa entre a atividade neuronal e a nossa mente, novamente, estamos percebendo como esse tipo de tecnologia, de microscopia do computador com os dados no mundo digital, este novo artefato digital, está mudando a forma como nós entendemos o ser humano.

IHU On-Line - O que isso significa?

Paolo Benanti - Significa que o desconforto é a reação que nós sentimos quando o nosso horizonte está mudando. Não nos sentimos numa zona de conforto, porque a forma que tínhamos para descrever o que precisamos fazer na realidade está mudando para sempre. E quando mudamos todo o horizonte, também o “por quê?” antigo muda.

Deixe-me ressaltar aqui as consequências teológicas, filosóficas e éticas dessa transformação. Para fazer isso, me permita contar a historinha do estudo da realidade que a filosofia e a ciência produziram para nós. Filósofos clássicos, como Aristóteles, Platão, os estoicos e também os Padres da Igreja [patrística], costumavam descrever o estudo da natureza através de categorias filosóficas. Vamos tentar resumir o que eles fizeram a partir de uma questão central reducionista, para que possamos entender o que está mudando durante essa era de transformação.

No modelo filosófico antigo, para a pergunta “Está chovendo?”, a resposta era “Está chovendo para permitir que a grama cresça”. Então, a explicação da realidade era feita através do “fim” [da finalidade]. Tudo que acontecia era explicado a partir do fim [da finalidade]. Se Aristóteles e Platão estivessem olhando para um leão e estudando o seu globo ocular, eles não se perguntavam “Que tipo de mudança de tecido permite que este tecido especial cresça dentro da cabeça do leão?”. Eles simplesmente perguntavam o que significa o globo ocular. A resposta durante essa época e na Idade Média era dada considerando o “fim” [a finalidade] de algo. Essa ideia é muito útil para os cristãos, porque a ideia de que tudo tem um fim é realmente fácil de se unir à ideia de que há um fim enorme [ao qual tudo responde]. Esse modelo era muito poderoso, realmente útil, e se manteve assim até que ficou complexo demais explicar a realidade.

No século XIII, quando a observação do cosmos não era mais simplesmente fácil de ser explicada como um "fim" – porque os planetas não estavam se movendo através do som, que era o fim e primeiro motor do universo –, aí algo se rompeu e não tínhamos mais um modelo que pudesse explicar a realidade. Com o fim desse modelo, como passamos a explicar a chuva? – para mantermos o exemplo que dei anteriormente. Passamos então a responder a mesma pergunta, “Está chovendo?”, de outra forma: quando uma corrente fria se encontra com uma corrente quente, se produz um vapor dentro dessa corrente, que se precipita e se transforma em gotas de água – as quais são atraídas pela gravidade da terra – e, então, chove. Ou seja, começamos a explicar a realidade através das “causas”. A abordagem científica, depois da abordagem filosófica da realidade, nos diz que quando se entendem as causas, se entende o modelo que está por trás das causas, isto é, é possível explicar tudo o que acontece depois. Esse é o modelo por trás da enorme transformação que ocorreu do século XVI até o século XX.

No século XX, este modelo das causas também desmoronou, porque se supunha que havia um espaço e tempo únicos, que Newton, no primeiro princípio da física, descreveu como modelo do universo. Resumindo essa longa história, quando Einstein simplesmente demonstrou que não existe um tempo absoluto e, com a teoria quântica, destruímos a ideia de um espaço uniforme, porque dizemos que um elétron só pode ter um tipo de jornada orbital ao redor do núcleo dos átomos, esse modelo também caiu por terra.

Mas, para continuar a nossa história, como respondemos agora à pergunta “Está chovendo?”. Bem, nós elaboramos outro modelo explicativo segundo o qual a resposta é: “Está chovendo quando o guarda-chuva está aberto”. Essa pode parecer uma resposta boba, mas espere um pouco. A última vez que você perguntou ao aplicativo do seu celular qual o caminho mais rápido para fazer com que você chegasse até um determinado destino, o Google Maps não contou para você as causas do tráfego; o que o aplicativo fez foi correlacionar a variação da velocidade dentro do acelerômetro do seu telefone celular ou do celular da pessoa que estava dirigindo. A correlação é a resposta para o modelo de pergunta que temos. Hoje, na era digital, é a correlação que nos dá a resposta para a nossa pergunta. É a correlação que conduz o nosso conhecimento sobre a realidade.

A realidade hoje é descrita como crenças conduzidas por dados. O que sabemos sobre a realidade é fornecido a nós pelos dados. Eles são a nova fonte de autoridade acerca do que acreditamos. Temos que reconhecer que a revolução digital está mudando o tipo de pergunta e a forma como respondemos a essa pergunta no nosso dia a dia. Há uma profunda transformação no modo como lidamos com a realidade, como a explicamos.

IHU On-Line – Que tipo de desafios temos por trás desse modelo?

Paolo Benanti – Para entender os desafios desse modelo, no mundo filosófico, ou seja, para ver qual é o problema epistemológico, tenho que contar outra história: a história de um judeu que, durante o domínio nazista na Europa, em 1940, fugiu para os Estados Unidos.

Muitos judeus foram forçados a fugir da Europa para não serem mortos em campos de concentração. Um desses judeus, que era alemão, fugiu para os Estados Unidos, e foi um dos que mais contribuiu para a derrota do exército nazista, sem nunca participar de uma batalha ou dar um tiro. Ele foi um matemático que trabalhou no Grupo de Pesquisa Estatística (SRG, em inglês), do governo dos EUA. O governo americano entendia que o país que ganharia a guerra seria aquele que tivesse 5% a mais de munição, aviões e tanques. O nome desse judeu era Abraham Wald e ele trabalhou por trás da otimização de um problema muito conhecido durante a Segunda Guerra Mundial.

Essa foi uma guerra tecnológica, que acabou com uma bomba atômica, mas o avião e os tanques eram as ferramentas de fato tecnológicas da guerra, as quais tornavam a batalha diferente naquela época. Uma das ferramentas mais poderosas durante a guerra era o avião; este era um maravilhoso artefato tecnológico que tinha a capacidade de voar, mas tinha um defeito: se fosse atingido por um tiro, tinha o inconveniente efeito colateral de cair e se destruir. Para evitar esse defeito, era preciso encontrar uma blindagem de aço para o avião, mas, ao mesmo tempo, não era possível utilizar esse tipo de blindagem pelo fato de o aço ser um material muito pesado, que faria o avião cair. O fato é que era preciso ter um reforço no avião. Para calcular o que fazer, o exército americano deu a Abraham Wald o mapa secreto dos furos de tiros que um avião costumava ter quando voltava de uma batalha – os tiros estavam muito mais localizados na parte central e na parte da cauda do avião.

Uma solução simples e cogitada era colocar mais aço nas partes do avião em que havia mais furos causados pelos tiros. Mas Abraham Wald fez uma objeção a essa proposta, argumentando que estavam analisando e considerando um avião que estava voltando da guerra e não um avião que havia sido praticamente destruído na batalha. Se considerasse apenas a primeira análise, ele dizia, bastaria apenas um tiro no motor ou um tiro no piloto para que o avião fosse derrubado. Essa discussão foi resolvida por Abraham Wald através de uma equação matemática.

O que é interessante para nós é que o questionamento dessa tecnologia [pressupõe] que há uma diferença entre números, valores, valores numéricos e significados. Uma variável de valor zero não é valor sem significado ou um insignificante. Existem variáveis de valor zero, mas isso não significa que sejam insignificantes. Chamamos esse viés de “viés de sobrevivência”. Essa é a primeira questão epistemológica com a qual temos que nos deparar dentro da área digital. Temos que poder, através de algoritmos e dados, prever e entender o que está acontecendo. Mas que tipo de verdade, de ferramenta epistemológica devemos produzir? Essa é uma questão teológica e filosófica também porque tem a ver com a questão da verdade.

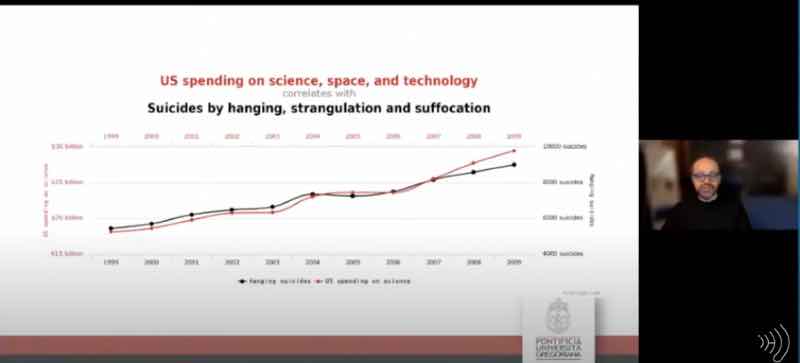

Correlação entre gastos dos EUA em ciência, espaço e tecnologia e suicídios por enforcamento, estrangulamento e sufocamento (Foto: reprodução do Canal do YouTube/IHU)

Nesse gráfico, foi feita uma correlação que não está correlacionada a nenhuma causalidade. Chamamos de correlações perfeitas entre os gastos em ciência, espaço e tecnologia dos Estados Unidos e o número de suicídios por enforcamento, estrangulamento e sufocamento nos EUA. Esses dois dados são perfeitamente correlacionados, mas não há causalidade entre eles. É falso que todo homem ou mulher que decide se suicidar nos Estados Unidos produziu ou produz um investimento muito maior em ciência, espaço e tecnologia. Como é falso que todo bilhão gasto pelos Estados Unidos nas viagens à Marte produz ou produziu mais suicídios entre os cidadãos. É uma falsa correlação. É simplesmente uma correlação espúria. Se dois dados estão correlacionados, não significa que eles têm uma causalidade. Portanto, correlação e verdade precisam ser explicadas.

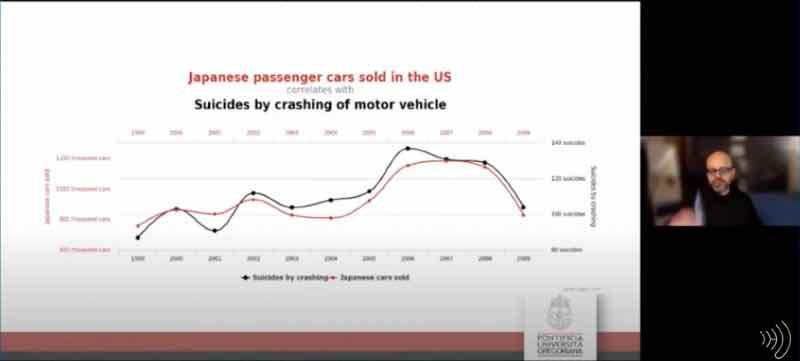

Correlação entre carros de passeio japoneses vendidos nos EUA e suicídios por acidentes de automóveis (Foto: reprodução do Canal do YouTube/IHU)

Esse [gráfico] é outro exemplo para mostrar que não se trata apenas de uma função linear. Aqui se vê uma perfeita correlação entre os carros de passeio japoneses vendidos nos Estados Unidos e o número de suicídios por acidentes de automóveis. Se tivesse uma causalidade dos dados, deveríamos dizer que toda vez que um carro Nissan é vendido nos Estados Unidos, alguém teria uma ideia suicida.

Podemos desenvolver essas ferramentas, que simplesmente se baseiam em algo que podemos definir como “vodu”, um tipo de abordagem religiosa dos dados. E aqui estamos no campo da teologia, porque há um certo “vodu” de correlação ou conexão de dados. Nós podemos acreditar nesse tipo de “vodu” como a nova religião na era digital. Podemos abordar isso do seguinte modo: “os dados estão dizendo” é como a nova resposta religiosa é dada a nós a partir desse tipo de oráculo, que é a máquina. Quando as pessoas dizem, “o Google disse x” ou “meus ancestrais diziam” ou “os deuses dizem”, temos de perceber que a correlação não implica a causalidade.

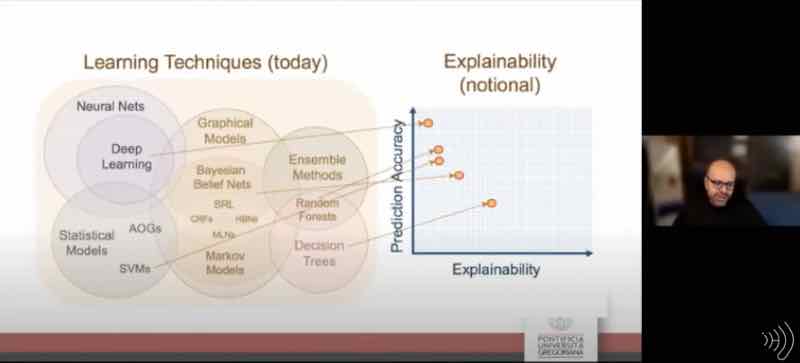

Técnicas de aprendizagem (Foto: reprodução do Canal do YouTube/IHU)

Isso é muito mais importante se olharmos, à esquerda nessa imagem [acima], as técnicas de aprendizagem. Os algoritmos mais poderosos que desenvolvemos hoje através da inteligência artificial são poderosos na previsão do que vai acontecer. O efeito poderoso da inteligência artificial é o de que ela pode me dizer algo antes disso acontecer e não depois. Graças a um algoritmo de rede neural da inteligência artificial, eu posso prever quando um motor de um carro vai estragar. Então, eu posso ir ao mecânico e consertar o motor, antes que estrague. Mas se os algoritmos são tão poderosos, especialmente na aprendizagem profunda, eles são muito fracos em me dar uma explicação emocional. Ou seja, eu posso permitir que uma máquina substitua a ação humana? Posso ter um algoritmo médico que seja bom na previsão da minha saúde; mas esse tipo de algoritmo pode decidir sobre a minha saúde, o meu futuro e a minha vida? Essas são escolhas que podem ser substituídas por uma máquina? Isso é algo que podemos permitir?

Se aplicarmos esse tipo de algoritmo aos dados produzidos por sensores de um processo de engenharia, como uma turbina a vapor, o algoritmo pode prever o que vai acontecer e vai poder nos informar algo cinco minutos antes de o motor estragar, e poderemos evitar um dano material e pessoal.

Mas tem um problema: se aplicarmos esse algoritmo não dentro de um processo de engenharia, mas com relação ao comportamento humano, o algoritmo não vai simplesmente prever o que vai acontecer, mas estará produzindo um novo tipo de comportamento. Se você comprar alguma coisa online, provavelmente vai receber uma sugestão dada por um algoritmo, que vai propor algo a você. Como todos os especialistas de marketing sabem, esse tipo de previsão e sugestão é também uma forma de produzir comportamentos nas pessoas, como o comportamento de comprar certas coisas. Nessa perspectiva, a tecnologia deve ser regulamentada para evitar que seja manipulada ou que manipule o comportamento das pessoas.

Outra questão: um algoritmo de inteligência artificial pode não errar dentro da previsão? Para resumir esse tópico, temos de reconhecer que essa é a “questão de [Pierre Simon] Laplace”, quando diz: se em algum momento eu souber toda a posição e a velocidade de todas as partículas do universo, eu vou saber o passado, o presente e o futuro. A teoria de Laplace seria equivalente aos dados? A questão é: os dados podem ser uma cópia perfeita da realidade? A resposta curta é não, porque os dados são um mapa da realidade. Se é assim, o sistema de inteligência artificial vai ser sempre falível, sempre haverá a possibilidade de falha.

IHU On-Line - Que tipo de perspectiva ética devemos propor para evitar um efeito indesejado?

Paolo Benanti – Primeiro, o medo do incerto. No mundo digital pode se prever algum tipo de instrução/realidade e temos de saber que esse tipo de indicação cognitiva dada pela máquina pode ter uma falha. Por isso, devemos levar em conta um princípio de precaução que nos dá algum tipo de segurança para permitir que esse sistema seja implementado dentro da sociedade. Precisamos lembrar também que a nossa sociedade é construída para preservar a igualdade e a busca da felicidade. Um algoritmo não pode produzir igualdade, porque ele pode permitir ou negar alguém de fazer algo.

O sistema central democrático dentro desse desenvolvimento tecnológico tem que desafiar o ambiente democrático, ou seja, tem que ser montado para permitir que a sociedade democrática entre nessa inovação.

IHU On-Line – Como fazemos isso?

Paolo Benanti – Para fazermos isso, minha sugestão é introduzirmos um novo capítulo dentro da ética. É o que eu chamo de "algor-ética" [algor-ethics]; não é uma nova ética, mas uma tradução da ética, uma forma de fazer a máquina entendê-la. Se uma máquina calcula, a algor-ética tem que ser a computabilidade para que uma máquina funcione de modo que coexista com o ser humano.

Muito mais do que o mundo digital, vamos mudar a relação entre nós; vamos substituir a decisão humana. Nesse sentido, a algor-ética tem que ser desenvolvida cada vez mais e implementada neste mundo.

Tomo a liberdade de provocar vocês com algumas perguntas. Estamos nos deparando com uma enorme transformação da era digital e devemos nos perguntar: qual é a verdade, o que é a epistemologia, e como podemos manter as coisas seguindo adiante de uma forma propositiva?