17 Julho 2021

"Ao contrário da IA, o cérebro e suas estruturas cognitivas não são máquinas rígidas. Pode-se dizer que a IA está tão entrelaçada com a mecânica da estrutura linguística que não pode sair dela. O cérebro, por outro lado, vai além da mecânica da qual é o criador e adiciona à 'análise' um número infinito de simulações sintéticas confiáveis de suas possíveis evoluções. Isso torna qualquer desalinhamento linguístico perceptivo e cognitivo um evento insignificante para o modelo constantemente reinventado com antecipação pelo cérebro".

A opinião é de Raul Gabriel, em artigo publicado por Avvenire, 01-07-2021. A tradução é de Luisa Rabolini.

Eis o artigo.

Os modelos linguísticos usados pelas máquinas são muito rígidos em comparação com as infinitas combinações possíveis da realidade. O cérebro, por outro lado, as reinventa constantemente porque sabe como antecipá-las.

Inteligência artificial (IA) imaginada como um organismo autogerador e independente é uma narrativa muito comum, útil para confundir o usuário médio para fins de mercado e outros, mas no momento se adapta apenas a contextos ficcionais. Na realidade, a IA se instrui, na verdade se compila. As filosofias subjacentes à programação neurolinguística (PNL) representam diferentes escolas de pensamento e dizem respeito à escrita dos padrões fundamentais na capacidade cognitiva constituinte da inteligência artificial.

São basicamente quatro: distributional semantics, frame semantics, model-theoretic semantics, grounded semantics. Não é um mero exercício técnico para especialistas. Cada um desses métodos determina consequências fundamentais para a nossa relação com o instrumento tecnológico e, consequentemente, incidem de forma importante sobre a nossa vida, dada a crescente difusão da nossa relação, nessas alturas osmótica, com os meios digitais e a web.

Sem perceber, acabamos assumindo estruturas lógico-linguísticas concebidas como pura aplicação matemático-estatística de associações em um ambiente desprovido de significado, aquele que regula a IA. Duas possíveis classes de danos decorrem disso: por um lado, uma padronização inevitável de nossas formas expressivas e de raciocínio que tendem, devido à superexposição, a imitar as formas mecânicas da inteligência artificial. Por outro lado, algo pior: a atribuição de significados a um aparato para-lógico e a operações linguísticas que não são desprovidas deles.

Simular a lógica da linguagem

A distributional semantics, como o nome indica, é baseada em uma hipótese distributiva: as semelhanças de significado estão relacionadas às porcentagens de distribuição. A aproximação semântica é entendida como aproximação da distribuição de um termo, e por extensão de sua repetição recorrente em determinados contextos. Quanto mais amplo for o contexto, quanto mais ampla for a distribuição, quanto mais estruturada for a interdependência dos âmbitos mais concretas são as possibilidades de se aproximar ao significado.

As abordagens da PNL são caracterizadas por uma dicotomia incontornável: intrínseca e extrínseca. Acredito que resulte bastante evidente que a distributional semantics, hoje amplamente usada em inteligências artificiais que tratam de linguagem, caia amplamente na categoria de extrínseca. Ou seja, o significado - poderia defini-lo como dimensão qualitativa do recurso "palavra" - não deriva de uma especificidade interna, mas de um atributo adquirido no uso, o vetor de distribuição, que evidentemente se abre para uma variedade sem limites de possíveis mal-entendidos.

Nos últimos 20 anos, numerosos estudos têm sido desenvolvidos para refinar a identificação de uma área semântica atendível obtida por meio da distributional semantics. O vetor distribuição e os contextos foram subdivididos em subáreas, cada vez mais especializadas e perimetráveis. Apesar disso, considero bastante difícil imaginar uma razoável eliminação dos erros. Estes são de relativo interesse para a IA aplicada, referente imaginário, uma vez que a abordagem do usuário, cada vez mais superficial e generalista, é mediamente satisfeita em termos funcionais pela média das soluções propostas.

Todos nós experimentamos diariamente algumas aplicações da distributional semantics: por exemplo, em sistemas preditivos de texto por meio das funções de autopreenchimento, quando digitamos algumas letras e toda uma série de opções possíveis aparecem entre termos e frases cujo vetor de distribuição resulta mais provável. O processo é puramente estatístico e sua reiteração pode nos induzir a imaginar associações de sentido totalmente inexistentes.

Substancialmente diferente no método e resultados é o frame semantics, a teoria do significado linguístico desenvolvida por Charles J. Fillmore. Ao contrário do anterior, alicerça-se mais propriamente no significado da palavra. A hipótese é que não existe um significado exaustivo que seja independente de suas possibilidades interpretativas e experienciais. Não consigo entender realmente a palavra "roda" se não conhecer a palavra "eixo", "engrenagem" ou ainda "pneu".

O frame semantics, como filosofia linguística aplicada ao humano, expande as possibilidades de significado, abre direções inesperadas, explora a complexidade ao nos forçar a apreciar uma abertura progressiva de enunciados. Isso muda como a aplicação da PNL, onde a determinação do significado assume um valor de reconhecimento não qualitativo. O frame semantics para IA qualifica o significado como decomposição da complexidade em partes menores que determinam sua identificação.

O frame semantics é útil, por exemplo, em sistemas como Alexa. A pergunta "Em que loja posso encontrar farinha?" é decomposto em "loja", "encontrar", "farinha" e assim por diante. O resultado é um funil cada vez mais estreito pela presença e especificidade das várias instâncias que levam à identificação de uma resposta chamada significado. Sem alterar que para a máquina trata-se de um processo horizontal, o frame semantics provavelmente oferece uma maior probabilidade de respostas confiáveis e congruentes.

Depois temos o model-theoretical semantics. Surge da hipótese de que todo o conhecimento humano pode ser codificado e modelado em uma série de regras lógicas. O motor predominante, neste caso, não é nem a distribuição dos elementos linguísticos nem o quadro de seu posicionamento, mas uma forma de verdadeiro silogismo dedutivo. As proposições que estão em relação através de alguns termos em comum determinam a suposição consequente de outras conexões entre os elementos considerados.

Se o cubo for vermelho e uma forma de X for um cubo, isso significa que aquela forma de X é vermelha. Esse tipo de lógica parece uma pedra angular. Se consigo programar a máquina de forma que ela seja capaz de prosseguir com essa lógica, então a máquina será capaz de gerar gradualmente mais expansões de significado, configurando uma espécie de habilidade gerativo-cognitiva.

Apesar de seu constructo aparentemente blindado, o model-theoretical semantics denuncia fragilidades a ponto de torná-lo obsoleto. As possíveis variáveis no modelo de silogismo aplicado à complexidade da realidade são tantas a ponto de invalidar gradativamente as conclusões.

Finalmente, temos a grounded semantics, que, como o termo indica, faz do pragmatismo seu ponto forte, uma especificidade abertamente anglo-saxônica. O fundamento não são modelos, nem contextos semânticos, nem deduções. O grounded semantics é baseado em fatos. Deles origina-se a linguagem que serve para descrevê-los, basicamente o principal mecanismo humano na raiz da linguagem, ainda que complicado por infinitas variáveis, pois o homem pode conceber uma abstração nunca totalmente alinhada com a experiência fenomênica, às vezes até contraposta ao próprio conceito de fato.

Na IA, esse método requer uma abordagem inversa da dinâmica humana, pelo menos na fase de "instrução". Primeiro, recebe a frase, “mova o círculo para a esquerda”, por exemplo. Em seguida, mostra-se a ela o movimento do círculo para a esquerda. Assume-se que ao longo do tempo a máquina possa dominar o mecanismo e inverter sua temporalidade, chegando ao ponto de “experimentar” um fato-evento para gerar consequentemente a linguagem apropriada. A maior limitação dessa abordagem é evidente: o panorama dos "fatos" possíveis é praticamente infinito e se combina com todos os outros fatos em combinações que abrem a complexidades inconcebíveis, de modo a inviabilizar a aplicação do grounded semantics.

Inteligência artificial rígida, cérebro humano flexível

O quadro das principais filosofias de instrução linguística aplicada à IA permite algumas considerações. Todas elas envolvem aspectos importantes na estruturação da lógica linguística humana. Cada um deles é obviamente emprestada da vasta gama de instrumentos à nossa disposição quando se trata de articular palavras, proposições, reflexões. No entanto, todas representam âmbitos muito parciais e resultam profundamente inadequadas se tomadas isoladamente. Ainda mais inadequadas quando confrontadas com o leque de possibilidades do cérebro humano, capaz de produzir incansavelmente novas exceções a qualquer estrutura dada.

Não se trata de um clichê, trata-se de aquisições muito recentes do mundo científico. A AGI (Artificial General Intelligence) é caracterizada por uma extrema complexidade, indissociável de uma fragilidade intrínseca. A fragilidade deriva de um dado essencial: a rigidez de cada sistema decorrente de uma aplicação das regras segundo esquemas mecânicos. Por mais que eu possa instruir uma máquina adicionando variáveis a variáveis ao mecanismo e aos componentes individuais que a habitam, nunca serei capaz de me desviar de uma linha essencialmente rígida. Aliás, quanto mais a complexidade aumenta, mais se incremente sua fragilidade.

A linguagem, entendida no sentido de uma organização cognitiva sistemática, é uma verdadeira arquitetura. Suas partes determinam reciprocidades funcionais vinculantes que, justamente como na física de um edifício, incidem sobre a sua estabilidade. Cargas, pressões e contrapressões, torções, amarrações mais ou menos superficiais, qualidade dos materiais são características essenciais de uma verdadeira “física da linguagem” que amplifica exponencialmente a variedade de chaves com as quais calibrar a codificação. E como na arquitetura, qualquer rigidez dos materiais pode levar a uma eventualidade potencialmente desastrosa: a quebra.

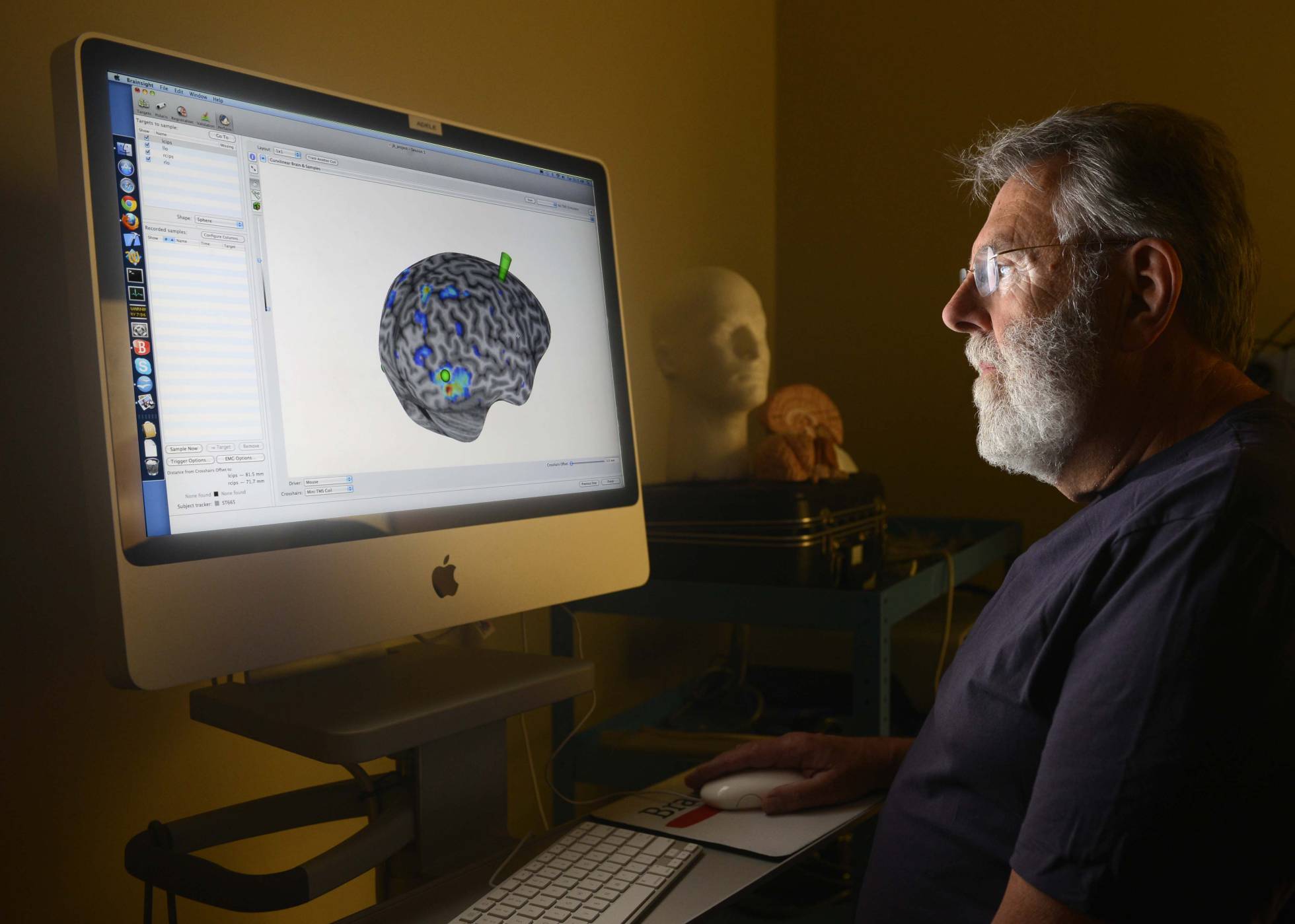

A estruturação da AGI tem um alicerce essencial no volume de dados e nos métodos com os quais os relacionar, sobre os quais se conta para tentar preencher a lacuna com o cérebro humano. Qual é o problema? A resposta está em uma característica específica do funcionamento das estruturas neocorticais cerebrais descobertas e estudadas por Vernon Mountcastle, neurofisiologista e professor emérito da Universidade John Hopkins.

Para resumir e chegar ao ponto que me interessa, o principal trunfo do neocórtex não é a sua já incrível articulação em termos de estruturas, cujo volume também poderia ser alcançado e ultrapassado pela quantidade de circuitos que a tecnologia é ou terá condições de colocar em sequência. Seu principal trunfo é o fato de ser uma máquina constantemente preditiva. Preditiva de modo exponencial. Constantemente em movimento, antes mesmo dos eventos (micro e macro) aconteçam.

Ao contrário dos esquemas enrijecidos pela complexidade progressiva que compõem a trama linguística da IA, o cérebro humano é dotado de estruturas que, além de reagir ao presente, elaboram continuamente quantidades de modelos evolutivos de curtíssimo prazo dessa realidade. Em outras palavras, o cérebro analisa e percebe a realidade, elabora-a, mas ao mesmo tempo gera sem parar e em todas as direções possíveis miríades de planos B, se quisermos chamá-los assim. Se algo der errado na primeira estrutura de avaliação, a substituição e o ajuste ocorrem praticamente sem solução de continuidade.

Ao contrário da IA, o cérebro e suas estruturas cognitivas não são máquinas rígidas. Pode-se dizer que a IA está tão entrelaçada com a mecânica da estrutura linguística que não pode sair dela. O cérebro, por outro lado, vai além da mecânica da qual é o criador e adiciona à "análise" um número infinito de simulações sintéticas confiáveis de suas possíveis evoluções. Isso torna qualquer desalinhamento linguístico perceptivo e cognitivo um evento insignificante para o modelo constantemente reinventado com antecipação pelo cérebro. Se algo varia, o cérebro está pronto com uma quantidade de adaptações já elaboradas, cuja "aplicação" resulta extremamente fluida.

Quando li a pesquisa de Jeff Hawkins em A thousand brains: a new theory of intelligence (Basic Books, 2021), recebi a confirmação do que há muito tempo defendo sobre a realidade como fato dinâmico, que inevitavelmente se derrama na forma estética e do corpo. Não é só uma minha convicção obviamente, mas na prática ainda hoje boa parte dos seres humanos rejeita esse dado efetivo, cultivando uma ideia inexistente de fixidez e assim se aproximando, sem saber, dos princípios estruturais e organizacionais que regulam a IA e decretam o seu limite intransponível. Num único instante produzimos tamanha riqueza de realidades possíveis que, se tivéssemos consciência disso, ficaríamos assombrados. Não é um pensamento romântico: é o hábito cientificamente comprovado do neocórtex que todos carregamos dentro da caixa mágica do crânio.

A estrutura cognitiva na qual o cérebro se baseia é estruturalmente resiliente, graças à sua natureza bioquímica, de uma forma desconhecida para qualquer IA atual. Diante dessas considerações apenas acenadas pela necessidade de espaço, entende-se como as filosofias subjacentes à PNL, todas concernentes a aspectos interessantes e parciais do problema, não podem representar uma resposta exaustiva na formação de uma verdadeira linguagem porque não tocam o verdadeiro tópico de uma estruturação linguística eficaz: a elasticidade dos modelos e sua regeneração. A rigidez das regras aplicadas ao deep learning system torna o sistema frágil. O aparato biológico cognitivo do cérebro humano, por outro lado, tem uma capacidade extremamente fluida de se adaptar às variações que podem derivar de erros, imprevistos, variáveis até mesmo mínimas, capazes de colocar em crise os mais complexos sistemas da IA.

A inteligência artificial persegue, o cérebro precede.

Leia mais

- Os desafios de uma tecnologia que sirva ao humano e não que se sirva do humano. Revista IHU On-Line, Nº. 544

- Homo Deus e a grande revolução algorítmica no século XXI. Revista IHU On-Line, Nº 516

- Inteligência artificial - A disputa entre a busca da eficiência e os desafios ético-morais. Entrevista especial com Brian Green

- Por uma inteligência artificial humanística. Entrevista com Paolo Benanti

- Como lutar contra o racismo da inteligência artificial

- Inteligência artificial: a máquina capitalista que pensa como uma empresa. Artigo de Paolo Benanti

- A inteligência artificial e o fim do trabalho. Artigo de Andrea Komlos

- Padre católico em Davos fala sobre inteligência artificial e fé

- Digitalização, política e inteligência artificial

- Organizadores de dados: a face oculta da inteligência artificial

- Uma Inteligência Artificial, prestes a resolver o “problema dos três corpos”

- Como a inteligência artificial poderia acabar com a Humanidade - por acidente

- Inteligência artificial com voz feminina

- Inteligência artificial e práticas cotidianas

- O irreversível avanço da inteligência artificial

- O trabalho e a inteligência artificial. Entre o temor e o otimismo