09 Junho 2023

Foi de Alan Turing a ideia de desenvolver uma tecnologia capaz de interagir com o usuário a partir da linguagem.

O comentário é de Paolo Benanti, frei franciscano da Terceira Ordem Regular, professor da Pontifícia Universidade Gregoriana, de Roma, e acadêmico da Pontifícia Academia para a Vida. Em português, é autor de “Oráculos: entre ética e governança dos algoritmos” (Unisinos, 2020).

O artigo foi publicado por Corriere della Sera, 15-05-2023. A tradução é de Moisés Sbardelotto.

Eis o artigo.

As inteligências artificiais fazem parte do nosso ambiente social e são um elemento essencial em quase todos os campos da atividade cotidiana. Usamos inteligências artificiais para pesquisar na internet, para fazer compras on-line, para viajar, para comunicar, para produzir bens, para fornecer serviços e para nos entretermos uns aos outros.

Estamos nos movendo, impulsionados por grandes empresas estadunidenses, rumo a uma transformação da sociedade que tornará necessária alguma forma de inteligência artificial para realizar a maior parte dos atos dentro do domínio social. Como chegamos a tudo isso?

Para responder a essa pergunta, o historiador francês Marc Bloch recorda-nos uma perspectiva fundamental: “A superstição da causa única, na história, nada mais é do que, muito frequentemente, a forma insidiosa da busca do responsável: portanto, do juízo de valor. ‘De quem é a culpa ou o mérito?’, diz o juiz. O estudioso se limita a perguntar ‘por quê?’ e aceita que a resposta não é simples” (“Apologia da história”).

Então, para responder à pergunta de fundo, ou seja, para entender como foi possível desenvolver esses softwares, devemos apresentar a complexa série de fatores que criaram as condições para o desenvolvimento da inteligência artificial e explicar como ela é o entrelaçamento de forças sociais e de fatores geopolíticos.

A obsessão pela velocidade

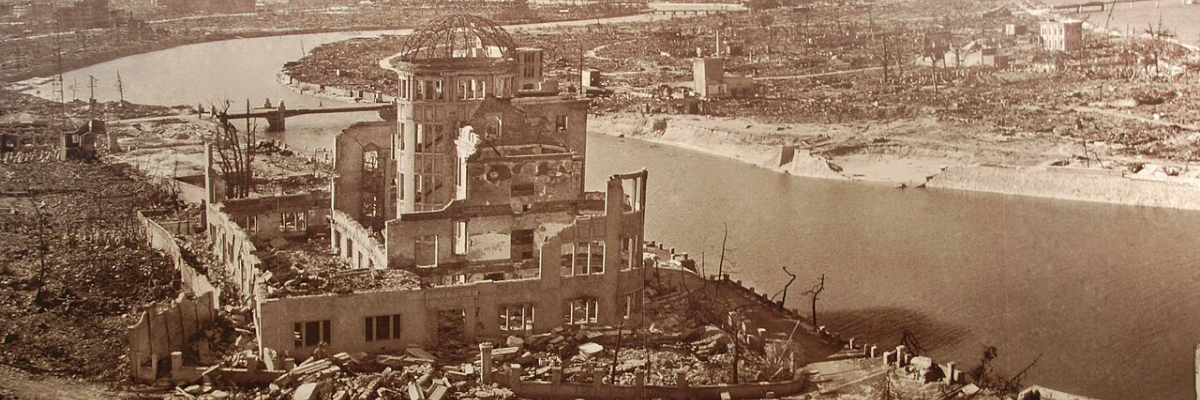

As origens da inteligência artificial remontam a meados do século passado, mais ou menos ao período em que nasceram os primeiros computadores. O computador foi fundamental para a realização da bomba atômica: era necessária uma enorme capacidade de cálculo para resolver as equações diferenciais capazes de determinar a força necessária para o impacto de um projétil de urânio sobre a massa de material físsil.

Embora não tenham cunhado o termo “inteligência artificial”, os cientistas John von Neumann e Alan Turing foram os pais fundadores da tecnologia que está em sua base: eles efetuaram a passagem dos computadores à lógica decimal do século XIX e das máquinas à lógica binária.

Os dois pesquisadores fundaram a arquitetura dos computadores contemporâneos dando origem a uma máquina universal, capaz de executar aquilo que é programado. Foi de Turing a ideia de desenvolver uma máquina capaz de interagir com o usuário, a partir da linguagem, com a mesma naturalidade e capacidade de resposta de um ser humano, de forma a ser indistinguível dele.

A separação entre Inglaterra e Estados Unidos

Isso também fez com que a perspectiva inglesa de Turing e a estadunidense se separassem nitidamente. Para os Estados Unidos, com o matemático Norbert Wiener à frente, o computador devia ter um desempenho cada vez maior: a velocidade na realização de cálculos em série era vista como indispensável para acelerar o planejamento e a realização de artefatos de guerra.

Turing não compartilhava a obsessão pela velocidade. Ele atribuiu tal escolha à fixação estadunidense de fazer coisas grandes, como ele escreveria em 1947. Quando as inteligências artificiais, hipotetizadas pelo inglês Turing, começaram a ser desenvolvidas nos Estados Unidos, elas sofreram essa influência metodológica.

O termo inteligência artificial é atribuído a John McCarthy, do Massachusetts Institute of Technology - MIT, e teve uma primeira definição graças ao matemático Marvin Minsky, da Carnegie-Mellon University. Segundo eles, a inteligência artificial consiste na “construção de programas de computador que se envolvam em tarefas que atualmente são executadas de forma mais satisfatória por seres humanos, pois requerem processos mentais de alto nível, como: a aprendizagem perceptiva, a organização da memória e o raciocínio crítico”.

Os seis criadores da inteligência artificial

Em 1956, na Dartmouth College, em New Hampshire, seis pessoas se reuniram, incluindo McCarthy e Minsky. Essa data é comumente considerada como a data de início oficial do nome “inteligência artificial” para identificar esse tipo de software.

Embora a ideia tivesse um certo fascínio, no início dos anos 1960 a popularidade da tecnologia sofreu um declínio: as limitações tecnológicas dos computadores impossibilitavam a realização do que se imaginava. No entanto, nasceram sistemas ainda hoje presentes nos sistemas modernos de inteligência artificial: as árvores de soluções para resolver problemas e a IPL, a linguagem de processamento de informações, que em 1956 permitiu a criação da “logic theorist machine”, que tentava demonstrar os teoremas matemáticos.

Em 1968, no filme “2001: Uma Odisseia no Espaço”, Stanley Kubrick propôs ao grande público todas as questões éticas que a inteligência artificial levanta ao ser humano: um computador – o HAL 9000, cujo nome, avançando cada letra em um caractere do alfabeto, é IBM – nos pergunta se uma inteligência artificial altamente sofisticada é algo bom ou um perigo para a humanidade. Autores como Kubrick e Philip K. Dick, na ficção científica, anteciparam as questões que hoje vemos como mais atuais.

Quando o Deep Blue derrotou Kasparov

No fim da década de 1970, graças à criação dos microprocessadores, a inteligência artificial despertou um novo interesse, levando à Era de Ouro dos sistemas especialistas. Em 1965, foi desenvolvido o Dendral, sistema especializado em química molecular, e, em 1972, o MYCIN, especializado no diagnóstico de doenças do sangue e na prescrição de medicamentos. Ambos os sistemas são fruto da pesquisa de grandes universidades e utilizavam um motor de inferência concebido como uma espécie de espelho lógico do raciocínio humano.

Esses resultados geraram um grande entusiasmo, mas novamente a paixão pelas inteligências artificiais se apagou entre o fim dos anos 1980 e o início dos anos 1990, porque era necessário um grande esforço de programação e, uma vez superadas as 200 ou 300 regras, verificava-se um efeito de caixa preta sobre o modo de raciocinar da máquina.

Além disso, o poder de cálculo dos computadores oferecia maneiras mais rápidas, menos complexas e menos dispendiosas de realizar tarefas semelhantes. Essa ilusão criou quase um tabu sobre o termo “inteligência artificial” nas universidades, e os cursos frequentemente mudavam de nome para coisas como “Cálculo avançado”.

Em maio de 1997, quando o Deep Blue, o sistema especialista da IBM, derrotou Garry Kasparov no xadrez, a opinião pública ficou chocada. No entanto, tal evento não gerou o desenvolvimento dessa forma de inteligência artificial. O sucesso do Deep Blue, como Turing já lamentava em 1947, baseava-se em um algoritmo sistemático de força bruta, no qual todos os movimentos possíveis eram avaliados e ponderados, e não em uma verdadeira inteligência do xadrez.

Ainda longe de modelar a complexidade do mundo

A derrota do ser humano permaneceu simbólica, mas o Deep Blue era uma inteligência artificial muito distante da capacidade de modelar a complexidade do mundo. A partir de 2010, assistimos a uma nova primavera das inteligências artificiais graças ao acesso a enormes volumes de dados e à descoberta da altíssima eficiência dos processadores de placas gráficas dos computadores para acelerar o cálculo dos algoritmos de inteligência artificial.

Essa nova tecnologia possibilitou alguns sucessos públicos significativos e aumentou os financiamentos no setor: em 2011, o Watson da IBM derrotaria os campeões do Jeopardy!, um popular jogo de TV em que, dada a resposta, devia-se adivinhar a pergunta. Em 2012, o Google X – o laboratório de pesquisas do Google – conseguiria fazer com que uma inteligência artificial reconhecesse gatos em um vídeo: pela primeira vez um computador aprendeu a distinguir algo. Em 2016, o AlphaGO do Google derrotaria no Go – um jogo muito mais complexo do que o xadrez, para o qual é impensável usar um sistema especialista com força bruta – o campeão europeu, Fan Hui, e o campeão mundial, Lee Sedol.

Universidades e investidores imprudentes

O salto de qualidade se deveu a uma completa mudança paradigmática em relação aos sistemas especialistas: uma abordagem indutiva não busca mais codificar regras, mas deixar que os computadores as descubram por conta própria por correlação e classificação, com base em uma enorme quantidade de dados.

Entre todas essas novas técnicas chamadas de machine learning, o deep learning é aquele em que mais se aposta. Em pouco tempo, a maioria das equipes de pesquisa passou a se confiar a essa tecnologia, com vantagens indiscutíveis. Assistentes virtuais, carros autônomos, diagnóstico médico e análise financeira são apenas alguns dos usos modernos da inteligência artificial obtidos graças à aprendizagem profunda.

A inteligência artificial está se desenvolvendo rapidamente, e os pesquisadores estão investigando novas ideias, como a aprendizagem por reforço, a computação quântica e a computação neuromórfica. Hoje, a inteligência artificial é capaz de interações mais semelhantes às humanas, com assistentes de voz como a Siri e a Alexa abrindo o caminho. O processamento de linguagem natural também fez progressos significativos, permitindo que as máquinas compreendam e respondam à linguagem humana com precisão cada vez maior.

Os riscos associados a investidores imprudentes

O ChatGPT – um modelo linguístico de grandes dimensões treinado pela OpenAI, baseado na arquitetura GPT que já chegou à versão 4 – é um exemplo de como a inteligência artificial, hoje, é capaz de processar a linguagem natural e gerar respostas semelhantes às humanas para uma ampla gama de perguntas e solicitações.

Hoje, porém, essas inteligências artificiais não são mais fruto de pesquisa universitária, mas de empresas de tecnologia e investidores imprudentes. Tudo isso nasce e é sustentado pela obsessão pela velocidade da cultura estadunidense. Para se ter uma ideia do que significava o uso do computador em termos de tempo de escrita e de cópia de dados na primeira década de sua existência, Herman Heine Goldstine, matemático e cientista da computação que trabalhou no Instituto de Estudos Avançados da Universidade de Princeton e contribuiu para o desenvolvimento do Eniac, a primeira máquina eletrônica de cálculo digital automática, escreveu maravilhado a seu colega Gillon sustentando que o Eniac era alucinante, porque podia resolver as equações diferenciais parciais de von Neumann em apenas 30 minutos: 28 para cortar os cartões perfurados e dois para calcular.

O computador evoluiu graças à rapidez de sua interface. A Microsoft, com seu MS-DOS, permitiu-nos usar o teclado no início dos anos 1980, fazendo com que evoluíssemos para o mouse em meados dos anos 1980. Com os smartphones e as telas sensíveis ao toque, aprendemos a usar os nossos dedos para sermos ainda mais rápidos. É por isso que não devemos nos surpreender se a grande revolução das inteligências artificiais como o GPT hoje é, acima de tudo, para acelerar ainda mais o uso dos computadores: o novo Bing e a ideia dos sistemas copilotos da Microsoft nada mais são do que a ideia de uma nova interface para o computador, a mais natural que temos, a nossa linguagem.

Hoje, a inteligência artificial não quer mais derrotar o ser humano. Ela quer se tornar seu companheiro inseparável, para alcançar aquela velocidade de relação com o computador que os Estados Unidos sonham há quase um século. Se esta breve história das inteligências artificiais do outro lado do Atlântico repassou as etapas mais importantes desse caminho, não devemos esquecer que este não é o único.

A abordagem europeia não deve ser subestimada: ela nos deu outros desenvolvimentos surpreendentes e nos permitiu investigar e tentar normatizar esses sistemas que chamamos de inteligentes.

Leia mais

- Depois da Inteligência Artificial. Artigo de Cosimo Accoto, Massimo Di Felice e Eliane Schlemmer. Cadernos IHU ideias, Nº. 48

- O Google se lança na guerra da Inteligência Artificial

- Riscos e preocupações em torno da inteligência artificial (IA). Artigo de Henrique Cortez

- Da ficção científica à realidade: os novos dilemas éticos da Inteligência Artificial. Entrevista especial com João Cortese

- Inteligência Artificial e meio ambiente. Artigo de Carlos Bocuhy

- “Se existe alguma maneira de controlar a inteligência artificial, devemos descobri-la antes que seja tarde demais”. Entrevista com Geoffrey Hinton

- Pausar desenvolvimento de IA não é suficiente. “Desliguem tudo”, alerta um dos fundadores da área

- Inteligência Artificial é uma ferramenta muito útil, mas não é inteligente. Entrevista especial com Walter Carnielli

- Pioneiro da IA deixa Google e alerta para risco à humanidade

- A inteligência artificial hackeia o sistema operacional da civilização humana. Artigo de Yuval Harari

- O aviso de Stephen Hawking, em 2014, sobre a inteligência artificial

- “A inteligência artificial não é uma ameaça, mas, se não a usarmos bem, pode se tornar”. Entrevista com Fredi Vivas

- A inteligência artificial e a espiral do caos. Artigo de Franco ‘Bifo’ Berardi

- ChatGPT contra o pensamento crítico. Entrevista com Noam Chomsky

- Éric Sadin: “O ChatGPT é um movimento civilizatório com profundas consequências antropológicas”

- ChatGPT: “Comunismo 2.0 ou a destruição em massa da humanidade”. Comentário de Rodrigo Petronio

- O ChatGPT tem alma? Uma conversa sobre ética católica e inteligência artificial com Blake Lemoine

- Quais os limites do Chat GPT na Saúde?

- ChatGPT: resta-nos habitar um cosmos de solidão. Comentário de Rodrigo Petronio

- O algoritmo gosta do discurso de ódio, diz Duvivier: 'A informação pertence a corporações'

- “É o século da solidão”, constata economista inglesa Noreena Hertz

- A era dos coletivos de solidão. Artigo de Boaventura de Sousa Santos

- A solidão na era das novas tecnologias de informação

- 'Redes sociais deixam sociedade mais vulnerável'

- ChatGPT, a heroína da Bayer? Artigo de Paolo Benanti

- Especialistas em inteligência artificial pedem uma pausa de seis meses para a “corrida fora de controle” do ChatGPT

- Bostificação, o futuro irresistível do ChatGPT

- Chapação maquínica, alucinação estatística: pensar como o ChatGPT

- Chomsky e o melodrama tecnofóbico. Artigo de Bruno Cava

- ChatGPT, tecnologia e programadores. E o bicho-papão da automação

- ChatGPT, o algoritmo que finge saber. Comentário de Bruno Cava

- GPT-4, o algoritmo inexplicável e fechado. Artigo de Paolo Benanti

- O homem tecnológico: protagonista ou vítima?

- O que Noam Chomsky pensa a respeito da Inteligência Artificial do ChatGPT

- As cinco perguntas sobre o sucesso do ChatGPT

- ChatGPT: nem monstro, nem tábua de salvação

- Castells: o que (não) penso sobre o ChatGPT

- ChatGPT: entenda como funciona a inteligência artificial do momento - e os riscos que ela traz

- ChatGPT. “Apesar da IA, ainda temos o monopólio da consciência”

- O GPT-3 desafia a inércia acadêmica

- Biopolítica algorítmica. Como as humanidades são impactadas e podem impactar a Inteligência Artificial. Entrevista especial com Virgilio Almeida

- Inteligência Artificial e Saúde: para todos ou para quase ninguém?

- Inteligência artificial democrática: software em vez da política? Artigo de Paolo Benanti

- “A inteligência artificial está se tornando senciente”, avisa engenheiro do Google. E Big G o suspende

- Dar uma ética à inteligência artificial: um desafio contado em livro

- A inteligência artificial não precisa de inteligência: o pensamento de Luciano Floridi

- “Ética da inteligência artificial”, novo livro de Luciano Floridi

- A necessidade de uma algorética para enfrentar o desafio da inteligência artificial. Artigo de Paolo Benanti

- É possível confiar na inteligência artificial?

- A inteligência artificial pode nos ensinar a ser mais humanos?

- Machine Intelligence: a inteligência artificial e a espionagem. Artigo de Paolo Benanti

- Inteligência Artificial no Sul Global. Alguns comentários a Jack Qiu

- “A inteligência artificial já faz parte da nossa cotidianidade.” Entrevista com Luciano Floridi