Pesquisadora apresenta um amplo panorama crítico da IA em perspectiva com a governança, accountability e a tecnodiversidade

Quando se fala em Inteligência Artificial - IA, tende-se a pensar a questão sob um viés radicalmente técnico e, na maioria das vezes, por meio de um viés a partir das lógicas do Norte Global, como se não houvesse outras maneiras de encarar o tema. “Não se trata apenas de regular artefatos técnicos, mas de repensar fundamentalmente como as estruturas de poder se reconfiguram na era algorítmica”, avalia Paola Cantarini, em entrevista por e-mail ao Instituto Humanitas Unisinos – IHU.

“Isso significa reconhecer que apenas podemos reconfigurar as tecnologias se reencantarmos as narrativas que as sustentam, superando a lógica instrumental que reduz a complexidade humana e social a padrões algorítmicos. Tudo começa, pois, com o imaginar futuros possíveis, ao invés de aceitar futuros preditivos pela IA, com uma redução da complexidade humana e de mundo, e onde destacamos a importância do pensamento crítico, da educação de qualidade e voltada não simplesmente à obediência e formar corpos dóceis, mas em um sentido mais profundo que vem se perdendo”, complementa.

A crise da democracia, impulsionada também pelas redes sociais e seus algoritmos comprometidos com um projeto político de extrema-direita, passa também pela necessidade, até agora adiada, de democratizar a própria democracia. “É necessário reimaginar a própria democracia. A era algorítmica nos confronta com o que chamo de ‘autoritarismo algorítmico’, onde sistemas opacos mediam a participação, filtram informações e reforçam desigualdades epistêmicas”, propõe.

“Como mostra Yuk Hui em sua proposta de ‘tecnodiversidade’, é fundamental superar a universalização da técnica ocidental e reconhecer que diferentes culturas desenvolvem relações distintas com a tecnologia. Isso implica não apenas ‘incluir’ perspectivas do Sul, mas questionar os próprios fundamentos ontológicos da IA atual, baseados numa razão instrumental que reduz a complexidade do mundo a padrões computáveis”, ressalta a entrevistada.

Por fim, Cantarini destaca que “ao invés de impor modelos algorítmicos baseados exclusivamente na racionalidade tecnocientífica ocidental, deveríamos desenvolver múltiplas ‘inteligências artificiais’ que reflitam diferentes formas de conhecimento e sabedoria, incluindo epistemologias indígenas, africanas, asiáticas e outras tradições não ocidentais. Iríamos do pensamento do cálculo, representacionista e reprodutivo para o poético, produtivo, criativo e múltiplo”.

Em evento promovido pelo IHU, Paola Cantarini ministrará a webconferência Castas digitais na era da IA. Os inúteis e os vigiados, no dia 7 de agosto de 2025, às 17h30min. A atividade é gratuita e com transmissão ao vivo pelo canal do IHU no Youtube. Para mais informações, acesse aqui.

Paola Cantarini (Foto: IEA/USP)

Paola Cantarini é advogada, professora universitária, bacharel, mestre e doutora em Direito (PUC-SP), doutora em Filosofia (PUC-SP) e em Filosofia do Direito (Univ. Salento/Unisalento-It.). Possui dez pós-doutorados em Direito, em Filosofia, em Sociologia e em IA em diversas instituições nacionais e internacionais de renome, com supervisores tais como Boaventura de Sousa Santos, Oswaldo Giacoia e Slavoj Zizek, (EGS/Suíça, Univ. Coimbra, PUC-SP-TIDD, USP/IEA – Cátedra Oscar Sala). É coordenadora acadêmica do CEADIN/USP/RP, da equipe de governança do projeto UAI/IEA/USP e colunista da Academia Baiana de Letras (TROPICAI). É membro do C4AI – Centro de Inteligência Artificial (USP) e fundadora do Instituto Ethikai.

IHU – Pode explicar o que é governança e o que seria uma governança de IA?

Paola Cantarini – A governança, em sua concepção clássica, refere-se aos mecanismos, processos e instituições através dos quais o poder é exercido e as decisões coletivas são tomadas. No contexto da inteligência artificial, a governança de IA transcende essa definição tradicional e, embora não haja um conceito unânime para governança, pode-se mencionar como um possível conceito a noção de abordar um conjunto complexo de desafios que emergem da intersecção entre tecnologia, sociedade e poder. Como venho argumentando em meus trabalhos, particularmente na proposta de uma governança multicamadas e participativa, não se trata apenas de regular artefatos técnicos, mas também de repensar fundamentalmente como as estruturas de poder se reconfiguram na era algorítmica.

A governança, em sentido amplo, é um conceito necessário dentro de uma abordagem de IA envolvendo, segundo nosso entendimento, a governança com as características essenciais de inclusão, democracia, multicamadas e multistakeholder; é uma proposta desenvolvida por mim em sede de pós-doutorado em IA, na Cátedra Oscar Sala, no Instituto de Estudos Avançados – IEA da USP e em um segundo pós-doutorado a respeito, na Faculdade de Direito da USP/RP. Em tais oportunidades coordenei a equipe de governança de dados e IA (Cátedra OS) e ainda sou coordenadora acadêmica no Centro de Estudos Avançados de Direito e Inovação – CEADIN da USP/RP, partindo do marco teórico que traz um modelo de governança modular, qual seja, artigo de Virgilio Almeida e Urs Gasser. Em tal artigo de 2017 (“A Layered Model for AI Governance”, 2017, IEEE. Internet Computing) os autores apostam em um sistema de governança de três camadas interligadas e focam na autorregulação e flexibilização da estrutura.

Contudo, por estar já defasada a proposta diante dos avanços atuais da IA, falando-se em IA generativa e Agentics AI, é essencial seu desenvolvimento, mesmo porque não traz camadas essenciais e não cita valores centrais. Procuramos contribuir para o debate ampliando a proposta inicial; segundo tal modelo, há três camadas interdependentes: técnica, ética e social/legal. Traz como ponto central, assim como nossa proposta, o conceito de governança multistakeholder, a partir de exemplos de casos concretos elogiados mundialmente no âmbito da internet, como o caso do NIC.br, CGI, onde trabalho no momento, mais especificamente no Observatório de Inteligência Artificial – OBIA.

Portanto, nossa proposta de governança multicamadas evolui para englobar também as camadas de infraestrutura, compliance, boas práticas, design, educação e conscientização, juntando a estas as demais camadas já citadas. O foco é trazer uma proposta efetiva para transformar princípios éticos e palavras bonitas em práticas que mudem a realidade, de forma a assegurar, de fato, accountability, transparência, controle democrático, respeito aos direitos fundamentais e participação cidadã. A governança de IA não deve ser apenas tecnocrática, mas deve incluir uma abordagem sociotécnica, conjugando-se teoria e prática, indicadores quantitativos e qualitativos, destacando ainda a importância da abordagem interdisciplinar, crítica, inclusiva, e com atenção, portanto, às desigualdades globais, epistemológicas e estruturais. Aposta no reconhecimento da interseccionalidade entre as diversas espécies de justiça que devem ser abordadas conjuntamente: de dados, algorítmica, ambiental, epistêmica e social.

Em suma, entendemos que é melhor adotar-se um conceito amplo de governança, que não se confunde com regulação, por exemplo, que seria apenas uma de suas fases em uma proposta de governança multicamadas. Neste sentido, por exemplo, temos o livro Oxford: governança de IA (“The Oxford Handbook of AI Governance, 2024, Oxford Press).

Outro ponto fundamental é considerar-se na governança de IA a incorporação não apenas de eficiência técnica, mas uma análise sociotécnica envolvendo legitimidade, accountability e deliberação pública, contrastando com modelos de autorregulação centralizada por Big Techs. É o que aponta o artigo do AI Now Institute (“Algorithmic Accountability: Moving Beyond Audits”), falando da necessidade de independência na pesquisa acadêmica e na insuficiência de se ter apenas auditorias com base em normas técnicas. É o caso, portanto, de exigirmos, ao menos para aplicações de IA de alto risco, uma auditoria independente e uma obrigatória avaliação de impacto algorítmico de forma prévia, ou seja, não a auditoria de 1ª e 2ª partes como se diz, mas de 3ª parte, por meio de institutos independentes, e com estrutura inclusiva, interdisciplinar e multistakeholder, a exemplo do Instituto Ethikai, que fundei e presido, o já citado AI Now Institute, Dair Institute e Orca Institute.

O último artigo referido destaca a importância da pesquisa independente e a insuficiência da auditoria técnica in verbis: “Por fim, essas propostas devem ser lidas no contexto de um ambiente cada vez mais precário para a pesquisa crítica sobre responsabilização tecnológica, no qual pressões econômicas deixam pesquisadores acadêmicos cada vez mais expostos à influência indevida de atores corporativos”. E continua: “Modos técnicos de avaliação há muito vêm sendo criticados por posicionarem de forma limitada o “viés” como uma falha dentro de um sistema algorítmico que pode ser corrigida e eliminada”.

Para se falar em IA inclusiva e democrática, é fundamental ampliar o olhar para os países do Sul Global e para as problemáticas que envolvem tais países de forma mais aprofundada como os ghost workers, o colonialismo de carbono e a soberania de dados, com base em obras tais como “Atlas of AI” (Kate Crawford), “Carbon Colonialism” (Laurie Parsons), “Ghost Work: How to Stop Silicon Valley from Building a New Global Underclass”(Mary L. Gray & Siddharth Suri), e em diversos relatórios e documentos internacionais que apontam para a lacuna de participação dos países do Sul Global e de propostas que trazem tal enfoque, já que a maioria traz ainda uma abordagem eurocêntrica. Exemplo paradigmático é o da Cúpula da Coreia do Sul de Maio/2024 e sua Seoul Declaration on AI Safety.

A governança de IA segundo tal proposta vai além dos modelos tecnocráticos dominantes, inspirando-se, entre outros, em autores como Antoinette Rouvroy e Thomas Berns, que partem da análise, em especial, de M. Foucault sobre o binômio poder-saber, e que denunciam como a governamentalidade algorítmica opera através da previsibilidade e eficiência técnica em detrimento da deliberação pública. Minha abordagem se fundamenta no conceito de “governança técnico-poética”, onde o imaginar e o imaginal, no sentido trabalhado por Henry Corbin, do “Mundus Imaginalis”, fazem parte da política, a se pensar como uma função política e de resistência, e, portanto, faz parte do governar. Isso significa reconhecer que apenas podemos reconfigurar as tecnologias se reencantarmos as narrativas que as sustentam, superando a lógica instrumental que reduz a complexidade humana e social a padrões algorítmicos.

Tudo começa, pois, com o imaginar futuros possíveis, ao invés de aceitar futuros preditivos pela IA, com uma redução da complexidade humana e de mundo, e onde destacamos a importância do pensamento crítico, da educação de qualidade e voltada não simplesmente à obediência e formar corpos dóceis, mas em um sentido mais profundo que vem se perdendo. E após isso conjugarmos tal teoria com inspirações mais práticas no sentido de mudar a realidade ao invés de apenas interpretar esta como já apontava Karl Marx nas suas críticas aos filósofos. Daí também a inspiração em Foucault novamente, que vai apontar para a importância da filosofia e dos filósofos em pensar os problemas da atualidade (filosofia do acontecimento, ontologia do presente) e sua postura ativista, assim como de outros pensadores de alto renome como Noam Chomsky.

Essa governança deve ser necessariamente multicamadas – abrangendo dimensões éticas, regulatórias, de compliance, infraestrutura, educação e design técnico – e multissetorial, garantindo participação efetiva de comunidades historicamente marginalizadas e trazendo diferentes autores para se garantir a interdisciplinariedade e a multiplicidade de visões. A OECD, em sua “Recommendation of the Council on Artificial Intelligence” (2019), já apontava para a necessidade de observatórios, mecanismos de prestação de contas e governança participativa, mas nossa proposta vai além ao incorporar epistemologias do Sul e uma perspectiva decolonial que questiona as assimetrias de poder epistêmico entre Norte e Sul Global.

O segundo ponto, quanto ao conceito de governança, é que não adotamos aqui o conceito tal como é apontado por Ignas Kalpokas ao considerar este no sentido dos algoritmos nos governar. Ignas Kalpokas, em “Algorithmic Governance: Politics and Law in the Post-Human Era” (2019, p. 13 e ss.) afirma que os regimes contemporâneos de governança algorítmica estão cada vez mais privatizados e mediados por plataformas digitais hegemônicas, que concentram poder e moldam comportamentos, instaurando uma forma de capitalismo de vigilância. Kalpokas caracteriza essa governança como polimórfica e deslocada da agência humana, uma vez que os algoritmos reconfiguram tanto sujeitos quanto objetos no ecossistema digital.

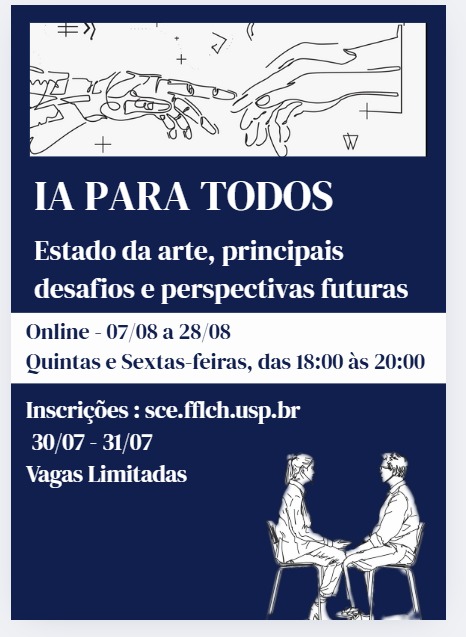

O curso será ministrado por Paola Cantarini, pelos professores do Ethikai e UAI pela USP. Para mais informações, acesse aqui

Apesar dos avanços em termos de uma estratégia brasileira de IA (com base nos principais documentos – EBIA e PBIA – “IA para o Bem de Todos”) e a par de pontos positivos, há algumas fragilidades. Como pontos positivos destacam-se: o objetivo de posicionar o país como líder global em IA promovendo avanços em infraestrutura, capacitação, serviços públicos, inovação empresarial e regulação. O documento aponta como desafios: ampliar investimentos em infraestrutura, P&D e inovação; assegurar a interoperabilidade e a robustez de dados. Fortalecer a formação e retenção de talentos ao apoiar o processo regulatório e de governança para garantir direitos e promover a inovação. Ainda como pontos fortes e em prol da infraestrutura e soberania há a previsão da aquisição de um supercomputador de alta performance e da criação de modelos de Inteligência Artificial em português, ou seja, incentivando a utilização de dados nacionais que refletem as características culturais e linguísticas brasileiras.

Contudo, há alguns pontos críticos e fragilidades, tais como: o desbalanceamento de investimentos, com pouco investimento nos setores de cibersegurança e energia elétrica, podendo comprometer a soberania digital e a resiliência das infraestruturas críticas; a falta de metas claras e indicadores: ausência de objetivos mensuráveis, prazos definidos e indicadores de sucesso, o que dificulta o monitoramento e a avaliação eficazes das ações propostas; a escassez de profissionais qualificados em IA no Brasil; a dependência de dados tradicionais como pesquisas e conjuntos de dados disponíveis, o que pode limitar a abrangência e a atualidade das análises; quanto ao OBIA, destaco a necessidade de ampliação da rede de colaboração e, inspirados no Observatório do OCED, seria interessante e importante trazer um observatório dos incidentes de IA. Dos nove eixos propostos, denota-se a ausência de governança de IA falando-se em governança de dados e infraestrutura, criação de repositórios abertos, interoperáveis e seguros, promoção da soberania digital e estímulo à utilização de dados públicos.

Como críticas e pontos de atenção, é possível destacar: a limitação da participação social – a consulta pública foi um avanço, mas o engajamento contínuo da sociedade civil, especialmente de grupos vulnerabilizados, ainda é frágil. Também há desconexão com práticas internacionais de auditoria e avaliação de impacto algorítmico (AIA): O PBIA não inclui ferramentas robustas como o AIA. Fala-se apenas no fortalecimento do português, esquecendo-se da multiplicidade linguística do nosso país.

IHU – O que é a justiça de dados?

Paola Cantarini – A justiça de dados, conceito central em minha abordagem e desenvolvido por autores como Linnet Taylor, Gargi Sharma, Aaron Martin e Shazade Jameson, representa uma resposta crítica e uma abordagem mais ampla que abrange temáticas como redistribuição de poder, reconhecimento das desigualdades estruturais e fortalecimento das vozes historicamente marginalizadas. Trata-se de uma perspectiva que parte da premissa de que os sistemas algorítmicos e as plataformas digitais são estruturas de poder e, como tais, devem ser analisadas sob as lentes da justiça distributiva, em uma chave intersecional com as demais justiças – epistêmica, ambiental e social.

Como demonstro em meus estudos, isso implica examinar criticamente quem tem acesso aos dados, quem os controla e quem se beneficia de sua monetização. O modelo dominante de coleta e exploração de dados é profundamente assimétrico, com grandes corporações e governos centralizando capacidades analíticas e computacionais, enquanto as comunidades afetadas têm pouca ou nenhuma participação nesse processo. Kate Crawford, em “Atlas of AI”, nos mostra como “cada instância de IA se apoia sobre camadas de extração, de recursos e de corpos”, revelando a materialidade oculta dessas tecnologias aparentemente imateriais.

A justiça de dados também se articula com o que Ulises Mejías e Nick Couldry denominaram “colonialismo de dados”, fenômeno que analiso em minhas obras. A coleta e o processamento de dados ocorrem em condições de extrema assimetria de poder, especialmente em contextos de baixa regulação como no Sul Global, onde populações inteiras se tornam fonte de extração de valor sem participar dos benefícios gerados. Projetos como “Our Data Bodies” (ODB) e “Data for Black Lives” (D4BL) exemplificam formas de resistência algorítmica e ação abolicionista que visam transformar dados em ferramentas de justiça para comunidades marginalizadas, demonstrando possibilidades concretas de democratização do poder sobre os dados.

A justiça de dados refere-se ao reconhecimento de que os dados – incluindo sua coleta, classificação, análise e uso – não são neutros, mas carregam implicações políticas, econômicas e sociais profundas, e reproduzem iniquidades. Outro ponto significativo é o fato de que os dados são fornecidos por todos nós de forma gratuita, envolvendo o que Shoshana Zuboff denomina de superávit comportamental. Isso porque, a partir de certo momento, eles não mais são coletados apenas pensando-se em “melhoria da experiência do usuário”, mas para muitas outras finalidades, e monetarizados de forma exponencial, muito além dos princípios da transparência, minimização de dados, finalidades específicas e consentimento fragmentado e informado. Tal matéria-prima é fundamental para a riqueza das big techs e não está havendo, até o momento, uma socialização dos benefícios da IA, para se falar em IA voltada ao interesse público ou “IA for good”, mas ao contrário, está a ocorrer uma maior concentração de riqueza, como apontam diversos relatórios, além da socialização das externalidades negativas, com maior impacto para o Sul Global, pois possui uma estrutura institucional mais fragilizada e que beneficia tal cenário.

Isto implica enfrentar as desigualdades estruturais e epistemológicas reproduzidas pelos sistemas algorítmicos, exigindo que as práticas de governança da IA levem em conta os contextos locais, as epistemologias do Sul Global e os impactos sobre populações vulnerabilizadas.

IHU – Diante de uma era de racionalidade algorítmica e opacidade epistêmica desses mecanismos, como podemos tornar a democracia mais sintonizada e eticamente alinhada com a diversidade do real?

Paola Cantarini – A resposta a esta questão central requer o que denomino de “reinvenção da imaginação política” e uma mudança ontológica fundamental em nossa compreensão da democracia. Como argumento em meus trabalhos, inspirada em autores como Mangabeira Unger, Boaventura de Sousa Santos e Danielle Allen, não basta regular a IA através de protocolos normativos ou cartas éticas; é necessário também reimaginar a própria democracia. A era algorítmica nos confronta com o que chamo de “autoritarismo algorítmico”, onde sistemas opacos mediam a participação, filtram informações e reforçam desigualdades epistêmicas, como documentam relatórios do Instituto V-Dem e da Freedom House sobre a ascensão global da autocratização.

A resposta passa por reconfigurar a democracia para além de modelos procedimentais ou formais. A democracia algorítmica deve incluir mecanismos de deliberação plural, participação informada, auditoria cidadã e transparência radical. É necessário reconhecer a crise da representatividade e da produção de sentido coletivo frente à lógica preditiva das IAs e investir em processos de contranarrativa, escuta ativa e inteligência coletiva, a partir da valorização da diversidade epistêmica e cultural.

É necessária uma mudança mais profunda, falamos em um “cultural shift” ou “poetic turn”, envolvendo uma mudança ontológica/epistemológica que começa por pensarmos por conta própria, de forma a decolonizar o próprio pensamento, como diz Mangabeira Unger, trazendo propostas autóctones, e repensar as estruturas em que se suportam tal sistema de IA injusto e antidemocrático, como pensar se a democracia representativa e as propostas de democracia participativa são ainda suficientes, ou se precisamos começar por pensar em democratizar a própria democracia (Boaventura de Sousa Santos). Neste sentido, apontamos para a importância de propostas que fogem do status quo, a exemplo das auditorias comunitárias e proposta de governança alternativa-indígenas, com base nos Care Principles (Canadá, Nova Zelândia, África, Índia).

Minha proposta se fundamenta no conceito de “insurgências quânticas”, evocando a articulação entre a física contemporânea e o campo social, onde os sujeitos insurgem-se como partículas livres num campo de opressões algorítmicas, rompendo com as previsibilidades dos sistemas fechados. Aqui, a metáfora do gato de Schrödinger se torna potente: a IA, enquanto não observada criticamente, pode conter infinitas formas de governar. A física quântica nos ensina que a partícula só se define no ato da observação – o real é potencial, um campo de possibilidades superpostas. Essa perspectiva quântica da governança acolhe a indeterminação, o devir, a criação, o múltiplo, exigindo abandonar as certezas e a lógica binária dos sistemas fechados.

A democratização da democracia, como propõe Boaventura de Sousa Santos, requer estruturas de democracia de alta intensidade que vão além da representação liberal clássica. Isso implica criar arquiteturas institucionais flexíveis, descentralizadas e responsivas às mobilizações de base, incorporando o que Weyl e Tang chamam de estruturas colaborativas entre humanos e IA, fundamentadas na diversidade, contestabilidade e responsabilização democrática. A proposta de uma “nova comuna digital” que desenvolvo visa garantir participação efetiva de parcelas vulneráveis da população em todas as etapas – do desenvolvimento à governança da IA –, transformando a relação entre técnica e humano numa dança poética de poder compartilhado.

IHU – De que ordem seria uma proposta de abordagem decolonial para a governança da IA?

Paola Cantarini – Uma abordagem decolonial para a governança da IA deve partir do reconhecimento de que a colonialidade se reconfigurou sob uma lógica tecnoeconômica que estrutura a governamentalidade algorítmica contemporânea. Como analiso extensivamente, baseando-me em autores como Aníbal Quijano, Walter Mignolo e Ramón Grosfoguel, a colonialidade do poder, do colonialismo de dados, tal como referi anteriormente, e o que Laurie Parsons caracteriza como “colonialismo de carbono”, revelam como as infraestruturas algorítmicas reproduzem e intensificam padrões históricos de dominação, exploração e exclusão sociotécnica.

Uma abordagem decolonial da governança da IA parte do reconhecimento das assimetrias históricas de poder, da colonialidade epistêmica e da subordinação dos saberes locais e indígenas. Tal proposta deve articular os direitos fundamentais com epistemologias do Sul, modelos de soberania de dados indígenas (como os Maori), justiça interseccional e participação comunitária. Visa construir uma IA que não reproduza padrões de exclusão, vigilância e extração de dados, mas que promova pluralidade, tecnodiversidade e justiça algorítmica.

A proposta decolonial que desenvolvo se articula em múltiplas dimensões. Primeiro, o questionamento epistêmico: os modelos de IA são majoritariamente treinados com dados do Norte Global, reproduzindo vieses culturais, linguísticos e socioeconômicos que invisibilizam cosmologias, ontologias e epistemologias do Sul Global. Como mostra Yuk Hui em sua proposta de tecnodiversidade, é fundamental superar a universalização da técnica ocidental e reconhecer que diferentes culturas desenvolvem relações distintas com a tecnologia. Isso implica não apenas “incluir” perspectivas do Sul, mas questionar os próprios fundamentos ontológicos da IA atual, baseados numa razão instrumental que reduz a complexidade do mundo a padrões computáveis.

Segundo, a dimensão material e geopolítica: como demonstra Kate Crawford em “Atlas of AI”, cada instância de IA se apoia em camadas de extração de recursos naturais e humanos, desde a mineração de terras raras até o trabalho de moderação de conteúdo realizado por populações precarizadas do Sul Global. Terceiro, a criação de alternativas propositivas e não apenas reativas: não se trata apenas de “resistir”, mas de “reexistir”, para lembrar uma palavra do saudoso teatrólogo José Celso Martinez Correia, e como propõem pensadores decoloniais. Isso implica desenvolver tecnologias baseadas em epistemologias plurais, que reflitam e integrem visões de mundo diversas, promovendo o que denomino “tecnodiversidade tropical”. Projetos como os citados por Ruha Benjamin com “ethos abolicionista” e o projeto “AcordAI” do Instituto Ethikai, no sentido de uma IA antropofágica, exemplificam possibilidades concretas de desenvolvimento tecnológico orientado pela justiça social e equidade racial, demonstrando caminhos para uma IA verdadeiramente inclusiva e democratizadora.

IHU – Qual a importância de termos em conta as múltiplas camadas de extração e exploração de recursos naturais e de trabalho humano, incluindo o garimpo com trabalho infantil, no qual a IA se sustenta?

Paola Cantarini – A IA não é uma tecnologia “etérea”: ela depende de cadeias de produção altamente materiais, baseadas na mineração de lítio, cobalto e outros minerais raros, muitas vezes extraídos com trabalho infantil, e em condições análogas à escravidão/servidão com trabalhadores invisíveis do Sul Global, sem quaisquer direitos trabalhistas, sem sindicalização, e com prejuízos até mesmo psicológicos, como ocorre com os que realizam a moderação de conteúdo altamente violento por diversas horas seguidas.

Também requer vastas infraestruturas de energia e armazenamento de dados que impactam o meio ambiente. Ignorar essas camadas significa reproduzir uma forma de cegueira ética e política. Portanto, uma governança justa de IA precisa ser também ecológica, laboral e global.

A visibilização das múltiplas camadas de extração que sustentam a IA é fundamental para desvelar o que chamo de “ontologia da perversidade” oculta por trás da promessa de neutralidade e progresso tecnológico. O capítulo “Earth” do livro de Crawford é particularmente revelador ao destacar que “cada instância de IA se apoia sobre camadas de extração, de recursos e de corpos”. Isso inclui não apenas a extração mineral necessária para a produção de chips e hardware, mas também o que podemos chamar de extração de dados e extração de trabalho cognitivo. O caso paradigmático da mina de lítio no Salar de Atacama no Chile, que analiso detalhadamente, exemplifica como o colonialismo de carbono opera: o metal essencial para baterias de dispositivos de IA é extraído através de processos que consomem enormes volumes de água e prejudicam ecossistemas frágeis, enquanto comunidades locais enfrentam escassez hídrica e degradação ambiental. Como aponta Parsons, “o carbono da tecnologia é externalizado para lugares onde a resistência é politicamente enfraquecida”.

Tal exemplo revela como o “progresso algorítmico” do Norte Global se sustenta numa cadeia de exploração profundamente assimétrica. Uma governança decolonial deve incorporar análises de justiça ambiental e questionar as externalidades negativas distribuídas desproporcionalmente entre países do Sul Global.

Além disso, a IA depende de uma cadeia global de trabalho invisibilizado e precarizado, desde o trabalho de moderação de conteúdo realizado por populações vulneráveis até o trabalho de etiquetagem de dados executado em condições de extrema exploração. Max Fisher, em “A máquina do caos”, documenta casos graves de violações de direitos humanos, incluindo genocídios em países do Sul Global como Myanmar, facilitados por algoritmos de redes sociais que amplificam discursos de ódio, fake news e desinformação. Isso revela como a aparente “eficiência” algorítmica se sustenta numa economia política global profundamente desigual, onde os custos sociais e ambientais são sistematicamente externalizados para populações e territórios periféricos.

A importância de tornar visíveis essas camadas de extração reside em seu potencial de desnaturalizar as narrativas hegemônicas sobre “progresso tecnológico” e “neutralidade algorítmica”. Como argumenta Crawford, métricas de eficiência energética são frequentemente manipuladas para justificar o crescimento desmedido da infraestrutura digital, constituindo formas de “greenwashing algorítmico” que obscurecem impactos ambientais reais.

O recente Summit Paris 2025, embora tenha apoiado a criação do primeiro Observatório Global para medição de energia de IA, ainda permanece limitado, pois dos diversos impactos ambientais de suma importância a serem analisados e mitigados foca apenas na energia, ou seja, não aborda adequadamente a distribuição desproporcional das externalidades negativas. Uma governança verdadeiramente democrática e decolonial da IA deve incorporar obrigatoriamente avaliações de impacto ambiental e social que proponham mitigação efetiva de danos, superando abordagens antropocêntricas que retratam o meio-ambiente apenas como objeto a ser explorado, em direção a uma perspectiva de “planet-centered AI”, que reconhece a natureza como sujeito de direitos.

IHU – Os sistemas mais conhecidos de IA generativa (ChatGPT e DeepSeek) são propriedades privadas. Como construir uma consciência ética e estética coletiva frente ao poderio das Big Techs?

Paola Cantarini – A resposta reside em movimentos de resistência digital, produção de alternativas tecnológicas coletivas, epistemologias comunitárias e estéticas dissidentes. A criação de redes de contra-hegemonia digital, observatórios públicos, auditorias cidadãs, comunitárias e públicas, e educação crítica são ferramentas essenciais para romper com o monopólio das Big Techs. Trata-se de ativar uma imaginação política e poética que recupere o comum e a dignidade informacional, como nos projetos propostos por movimentos como o Instituto Ethikai, construídos em torno de conceitos centrais como o de Ethics by Design e Ethics as a Service, com foco em direitos fundamentais e governança de IA voltados aos países do Sul Global, repensando as vulnerabilidades gerais e específicas existentes atualmente para trazer medidas de mitigação de danos.

A construção de uma consciência ética e estética coletiva frente ao poder das Big Techs requer uma “profanação algorítmica”, conceito que desenvolvo com inspiração em Walter Benjamin e Giorgio Agamben. Profanar a IA significa devolver ao uso comum aquilo que foi sequestrado pelo sagrado corporativo, libertando-a da captura pela racionalidade capitalista. Como argumento em minha proposta “AcordAI”, trata-se de um chamado poético à consciência crítica, à insurgência estética e à ação coletiva sobre as tecnologias, superando as limitações das abordagens puramente técnico-solucionais para a governança da IA.

A hegemonia das Big Techs se sustenta não apenas no controle de infraestruturas computacionais, mas fundamentalmente na captura do imaginário coletivo sobre o futuro tecnológico. Como analisa Shoshana Zuboff, em “A Era do Capitalismo de Vigilância”, essas corporações operam através de uma lógica de extração comportamental que converte a experiência humana em dados para alimentar mercados preditivos. Plataformas como Facebook, TikTok e YouTube não apenas distribuem conteúdo, mas moldam percepções, afetos e preferências políticas através de algoritmos opacos, configurando o que Byung-Chul Han chama de “psicopolítica digital”. O escândalo da Cambridge Analytica exemplifica como essa manipulação emocional em escala massiva corrói a esfera pública e compromete processos democráticos.

A resposta que proponho articula múltiplas dimensões de resistência propositiva. Primeiro, a criação de alternativas tecnológicas: projetos como “Abolitionist Tools”, “Just Data Lab” e movimentos como o Afrofuturismo demonstram possibilidades concretas de desenvolvimento de ferramentas que priorizam justiça social e equidade em detrimento do lucro e controle. Segundo, a mobilização de epistemologias plurais: como mostra Ruha Benjamin em “Race After Technology”, comunidades marginalizadas desenvolvem formas criativas de resistência e subversão dos sistemas opressivos, utilizando arte, organização comunitária e inovação tecnológica para desafiar narrativas dominantes e promover visões alternativas de futuro. Terceiro, a construção de uma “nova comuna digital” que democratize não apenas o acesso, mas fundamentalmente o poder de decisão sobre os rumos tecnológicos.

Isso implica superar a lógica da “participação tokenizada” do Sul Global e representantes de parcelas vulneráveis em consultas públicas e avançar para estruturas de cogovernança radical que incorporem efetivamente vozes historicamente marginalizadas nos processos de design, desenvolvimento e governança algorítmica. Como propõem Weyl e Tang em “Plurality”, precisamos de arquiteturas colaborativas entre humanos e IA fundamentadas na diversidade, contestabilidade e responsabilização democrática. A construção dessa consciência coletiva passa necessariamente pela reengenharia institucional que assegure transparência algorítmica, supervisão humana significativa e direitos substantivos à contestação e revisão humana, criando contrapoderes efetivos ao domínio tecnocrático das Big Techs.

IHU – É possível deslocar o caráter antropocêntrico da IA em favor de uma tecnologia baseada na Planet-Centered AI? O que é esta alternativa?

Paola Cantarini – Sim, é possível e urgente. A proposta de uma Planet-Centered AI, ou life-centered AI propõe superar o paradigma antropocêntrico em favor de uma tecnologia que considere as interdependências entre humanos, natureza e sistemas técnicos. Baseia-se em uma ética do cuidado, da reciprocidade e da sustentabilidade, incorporando princípios como o bem viver, o respeito aos ecossistemas e a corresponsabilidade intergeracional.

A transição do “human-centered AI” para o “planet-centered AI” representa uma mudança ontológica fundamental que venho desenvolvendo como alternativa ao antropocentrismo que caracteriza os modelos dominantes de inteligência artificial. Como argumento em meus trabalhos, o antropocentrismo da IA atual não apenas reproduz hierarquias opressivas entre humanos, mas também naturaliza uma relação instrumental com a natureza que a reduz a mero recurso disponível para exploração. O “planet-centered AI” que proponho se inspira nas cosmologias indígenas, nas epistemologias do Sul e em abordagens ecocêntricas que reconhecem a natureza como sujeito de direitos, superando a dicotomia cartesiana entre cultura e natureza.

Essa proposta se fundamenta no reconhecimento de que a crise climática e a crise democrática são inseparáveis da crise tecnológica contemporânea. O Doomsday Clock [relógio do fim do mundo], que aponta para 89 segundos para a destruição planetária em 2025, evidencia a urgência de incorporar obrigatoriamente avaliações de impacto ambiental nas regulações de IA superando abordagens incipientes e generalistas que tratam o meio ambiente como variável secundária.

O “planet-centered AI” implica uma reconfiguração radical tanto das infraestruturas quanto das epistemologias que orientam o desenvolvimento tecnológico. Primeiro, a dimensão infraestrutural: isso significa priorizar eficiência energética real (não apenas métricas manipuláveis de greenwashing), desenvolver arquiteturas computacionais inspiradas em sistemas naturais (como redes neurais bioinspiradas que operam com consumo energético mínimo), e criar sistemas de economia circular que minimizem a extração de materiais. Segundo, a dimensão epistemológica: incorporar saberes tradicionais e indígenas sobre sustentabilidade, desenvolver algoritmos baseados em princípios de reciprocidade e interdependência (em oposição à lógica extrativista) e criar sistemas de IA que operem em harmonia com ciclos naturais ao invés de impor temporalidades artificiais aceleradas.

Essa abordagem se articula com o conceito de negantropoceno, de Bernard Stiegler, que propõe respostas criativas e regenerativas à entropia digital, e com a proposta de Yuk Hui sobre cosmotécnicas, que reconhece que diferentes culturas desenvolvem relações específicas com a técnica baseadas em suas cosmologias particulares. Projetos práticos nessa direção incluem o desenvolvimento de algoritmos de otimização inspirados em processos ecológicos, sistemas de IA para monitoramento e proteção de biodiversidade desenvolvidos em colaboração com comunidades tradicionais, e plataformas digitais baseadas em princípios de commons e sustentabilidade. O objetivo não é romantizar a natureza, mas reconhecer que a inteligência artificial genuinamente benéfica deve operar em sintonia com os sistemas planetários que sustentam toda forma de vida, incluindo a vida humana.

IHU – Como a proposta de Yuk Hui da tecnodiversidade pode apontar pistas sobre uma IA que seja inclusiva e eticamente responsável?

Paola Cantarini – Yuk Hui propõe a tecnodiversidade como uma alternativa à homogeneização tecnológica imposta pela racionalidade técnica ocidental. Ele defende que diferentes culturas devem desenvolver suas próprias tecnologias de acordo com suas cosmologias, valores e modos de vida. Isso implica reconhecer e valorizar formas plurais de saber, de tempo e de relação com o mundo. A tecnodiversidade é, portanto, um princípio ético e político que orienta a criação de IAs localizadas, contextualmente sensíveis e politicamente inclusivas.

A proposta de tecnodiversidade de Yuk Hui oferece uma crítica fundamental ao universalismo tecnológico ocidental e aponta caminhos essenciais para uma IA verdadeiramente inclusiva e eticamente responsável. A ideia de que existe uma única forma “universal” de tecnologia representa uma violência epistêmica que invisibiliza as múltiplas maneiras através das quais diferentes culturas desenvolvem relações específicas com a técnica baseadas em suas cosmologias particulares. A tecnodiversidade propõe que, assim como existe biodiversidade no mundo natural, deve existir diversidade tecnológica no mundo cultural, diversidade epistêmica, superando a homogeneização técnica imposta pela racionalidade instrumental ocidental.

Hui demonstra que diferentes tradições culturais desenvolvem o que chama de cosmotécnicas – articulações específicas entre o cosmo (ordem moral e cósmica) e a técnica que refletem ontologias e epistemologias distintas. Por exemplo, a relação com a tecnologia na tradição chinesa difere fundamentalmente da tradição ocidental não apenas em termos de aplicação, mas em termos de compreensão ontológica do que significa técnica e qual deve ser sua relação com o humano e o natural. Isso tem implicações profundas para o desenvolvimento de IA: ao invés de impor modelos algorítmicos baseados exclusivamente na racionalidade tecnocientífica ocidental, deveríamos desenvolver múltiplas inteligências artificiais que reflitam diferentes formas de conhecimento e sabedoria, incluindo epistemologias indígenas, africanas, asiáticas e outras tradições não ocidentais. Iríamos do pensamento do cálculo, representacionista e reprodutivo para o poético, produtivo, criativo e múltiplo.

A aplicação da tecnodiversidade ao campo da IA que proponho envolve múltiplas dimensões práticas. Primeiro, a diversidade de dados e representação: superar o viés de dados majoritariamente oriundos do Norte Global e incorporar formas plurais de conhecimento, incluindo saberes orais, tradicionais e comunitários que operam segundo lógicas diferentes da escrita e da quantificação. Segundo, a diversidade de objetivos e valores: em vez de otimizar exclusivamente para eficiência e lucro, desenvolver sistemas orientados por valores como reciprocidade, cuidado, sustentabilidade e bem viver (sumak kawsay), conceitos centrais em cosmologias indígenas. Terceiro, diversidade de arquiteturas e processos: experimentar com formas de processamento de informação inspiradas em diferentes tradições de conhecimento, como sistemas baseados em narrativas, redes relacionais, ou processamento holístico ao invés de analítico.

Projetos concretos nessa direção incluem iniciativas como o desenvolvimento de sistemas de IA para preservação de línguas indígenas que respeitam protocolos culturais específicos, algoritmos de recomendação baseados em valores comunitários ao invés de maximização de engajamento individual, e plataformas de conhecimento que integram ciência ocidental com saberes tradicionais de forma não hierárquica. Como argumenta Hui, não se trata de relativismo cultural, mas de reconhecer que a atual universalização da técnica ocidental representa uma forma de colonialismo tecnológico que empobrece a diversidade humana. Uma IA verdadeiramente inclusiva deve ser capaz de operar segundo múltiplas lógicas cosmotécnicas, criando espaços para que diferentes tradições de conhecimento contribuam para soluções tecnológicas mais ricas, sustentáveis e democraticamente legitimadas.

IHU – A senhora argumenta que a colonialidade funciona hoje em uma lógica tecnoeconômica que estrutura a governamentalidade algorítmica, baseada na previsibilidade e na eficiência técnica em detrimento da deliberação pública e do controle social. Como tornar as tecnologias mais sociais quando todas as pistas indicam a direção contrária?

Paola Cantarini – O caminho é o da construção de espaços contra-hegemônicos de produção tecnológica, auditáveis e abertos à deliberação pública. A governamentalidade algorítmica deve ser desnaturalizada, denunciando-se sua pretensa neutralidade. Devemos promover uma virada ética, institucional, cultural e poiética que reposicione o humano, o comum e o coletivo como eixos centrais da ação técnica. Isso passa por práticas de cogovernança, ecossistemas de confiança e redes de solidariedade interterritorial.

Esta questão toca no cerne do que considero o desafio político fundamental de nosso tempo: como recuperar o político e a capacidade de imaginação coletiva numa era em que a lógica algorítmica busca sistematicamente substituir a deliberação pela predição e a representação pelo controle. Como analiso extensivamente, baseando-me em Antoinette Rouvroy e Thomas Berns, a governamentalidade algorítmica opera através de uma racionalidade que privilegia a previsibilidade e eficiência técnica precisamente para contornar os “inconvenientes” da deliberação democrática, da contestação pública e da incerteza política. Essa lógica colonial contemporânea se manifesta não apenas através da dominação geopolítica, mas fundamentalmente através da colonização do futuro, transformando possibilidades abertas em trajetórias pré-determinadas por algoritmos.

A resposta que desenvolvo se articula através do conceito de insurgências quânticas e da necessidade de uma revolução epistêmica que vá além das soluções técnico-regulatórias. Como argumento, inspirada na física quântica, o real é um campo de possibilidades superpostas que só se define no ato da observação crítica. A governança “quântica” da IA que proponho acolhe a indeterminação, o devir, a criação, o múltiplo, abandonando as certezas e a lógica binária dos sistemas fechados, a favor de devires, porvires e multiplicidades. Isso implica criar o que chamo de “linhas de fuga” algorítmicas, espaços onde a previsibilidade do sistema pode ser rompida através da ação coletiva organizada, da criatividade social e da imaginação política.

A proposta de uma nova comuna digital que desenvolvo visa institucionalizar essas práticas através de estruturas de cogovernança radical que garantam uma participação efetiva de populações vulneráveis não apenas como “usuárias” ou “consultadas”, mas como protagonistas dos processos de design, desenvolvimento e governança algorítmica.

Isso requer o que denomino “reengenharia institucional” profunda: criação de observatórios cidadãos de tecnologia com poder efetivo de auditoria e veto, desenvolvimento de plataformas digitais baseadas em princípios de commons ao invés de propriedade privada, e estabelecimento de direitos digitais substantivos que incluam não apenas acesso, mas poder de contestação, modificação e recusa tecnológica. Demandaria ainda a reconfiguração do sistema de direitos humanos e um novo bill of human rights, com o reconhecimento e proteção adequada de novos direitos humanos/fundamentais como os neurodireitos, em especial o direito ao sonho como uma nova dimensão de tais direitos, tal como minha proposta e desenvolvimentos (coluna TropicAI da Academia Baiana de Letras, Jornal USP, artigo como articulista em coluna do jornal Migalhas).

Como propõem Weyl e Tang em “Plurality”, precisamos experimentar com arquiteturas colaborativas entre humanos e IA que operem segundo lógicas de “democracia líquida” e participação contínua. A socialização da tecnologia não emerge espontaneamente, mas requer organização política deliberada, financiamento público substancial para alternativas democráticas, e principalmente uma mudança cultural que reconheça a tecnologia como bem comum a ser governado coletivamente, não como propriedade privada a ser maximizada para lucro.

IHU – O que significa estabelecer uma regulação da IA que ultrapasse o caráter de transparência técnica, mas envolva, também, “accountability” política e participação cidadã efetiva?

Paola Cantarini – Significa reconhecer que a simples abertura de códigos ou relatórios técnicos não garante justiça ou legitimidade. É preciso estabelecer mecanismos de responsabilização institucional, auditoria algorítmica independente, participação multissetorial e consulta pública contínua. A regulação da IA deve ser orientada por princípios de “fundamental rights by design”, justiça epistêmica, governança multilayered e por um novo pacto democrático que inclua o cidadão como coprotagonista da vida digital.

Estabelecer uma regulação da IA que transcenda a transparência técnica significa reconhecer que a governança algorítmica é fundamentalmente uma questão de poder e democracia, não apenas de otimização técnica. Baseando-me no relatório “Algorithmic Accountability: Moving Beyond Audits” do AI Now Institute, a insuficiência das auditorias puramente técnicas (como normas ISO/NIST) reside no fato de serem vocacionadas à eficiência operacional, não aos direitos humanos e fundamentais e não considerarem as particularidades e assimetrias específicas dos países do Sul Global. Uma regulação verdadeiramente democrática deve incorporar o que chamo de “accountability política” – mecanismos que tornem os sistemas algorítmicos responsáveis perante as comunidades afetadas e sujeitos a controle social efetivo.

A accountability política que proponho opera através de múltiplas dimensões institucionais. Primeiro, a criação de observatórios cidadãos de tecnologia com mandato legal para realizar auditorias independentes, poder de acesso a códigos e dados, e capacidade de suspender sistemas que violem direitos fundamentais. Esses observatórios devem ser compostos de forma interdisciplinar e pluralista, incluindo não apenas especialistas técnicos, mas representantes de movimentos sociais, comunidades afetadas, pesquisadores críticos de tecnologia, e defensores de direitos humanos. Segundo, o estabelecimento de direitos digitais substantivos que vão além do acesso formal para incluir direitos à contestação algorítmica, revisão humana qualificada, e recusa tecnológica sem penalização. Terceiro, a institucionalização de processos de “avaliação de impacto democrático” que analisem não apenas riscos técnicos, mas impactos sobre deliberação pública, pluralismo político, e equidade social.

A participação cidadã efetiva que defendo transcende as consultas públicas tokenizadas que caracterizam a maioria dos processos regulatórios atuais. Inspirada em experiências como os orçamentos participativos e as conferências nacionais brasileiras, proponho estruturas de cogovernança algorítmica que garantam participação continuada de populações historicamente marginalizadas em todas as etapas do ciclo tecnológico. Isso inclui: comitês de acompanhamento com representação proporcional de grupos vulneráveis, processos de auditoria participativa, onde comunidades afetadas podem questionar e propor modificações em sistemas algorítmicos, e a criação de fundos públicos para financiar pesquisa independente e desenvolvimento de alternativas tecnológicas orientadas por justiça social. É o que se denomina de abordagem participativa, co-design, ou co-production, community engaged approach, a exemplo de co-design workshops como metodologias participativas em iniciativas de IA no setor público, ou participatory approach, co-approach, a exemplo da Montreal Declaration (2017), falando de coconstrução, envolvendo mais de 500 cidadãos e especialistas.

A construção prática dessa arquitetura regulatória requer superação de obstáculos estruturais significativos. Como documenta o AI Now Institute, existe um “ambiente cada vez mais precário para pesquisa crítica sobre responsabilização tecnológica”, onde pressões econômicas deixam pesquisadores acadêmicos expostos à influência corporativa indevida.