12 Fevereiro 2020

A inteligência artificial não é neutra, reproduz nossos preconceitos sociais. O problema é que isso pode ter consequências prejudiciais para setores que já estão marginalizados na sociedade, em áreas delicadas como a saúde.

A reportagem é de Gabriela Martinez, publicada por Ctxt, 06-02-2020. A tradução é do Cepat.

É, por exemplo, o caso de um algoritmo amplamente utilizado no sistema de atenção médica dos Estados Unidos. Isso tem um viés racial que reduz em mais da metade o número de pacientes negros que provavelmente receberão cuidados adicionais, como demonstra um estudo publicado na revista Nature.

Assim, o sistema gasta menos dinheiro em pacientes negros, que têm o mesmo nível de necessidade dos brancos, e o algoritmo conclui falsamente que os pacientes negros são mais saudáveis. Embora o problema tenha sido detectado no sistema da empresa Optum, é muito provável, segundo os cientistas, que o mesmo fenômeno seja reproduzido em ferramentas usadas por outras agências que a cada ano gerenciam a saúde de 200 milhões de pessoas no país norte-americano.

Não são casos isolados. De acordo com o balanço de 2019 do AI Now Institute, centro da Universidade de Nova York que investiga o impacto social da inteligência artificial, esta continua ampliando as disparidades raciais e de gênero. Um caso paradigmático foi o dos algoritmos “sexistas” do cartão de crédito Apple Card. A empresa foi acusada de oferecer limites de crédito muito maiores a homens do que mulheres e a controvérsia desencadeou investigações tanto pelo Comitê de Finanças do Senado dos Estados Unidos, como pelo Departamento de Serviços Financeiros do Estado de Nova York.

Não há maldade na tecnologia

Se muitas vezes aqueles que programam esses algoritmos não são conscientes do que fazem, menos ainda são os próprios algoritmos. “Por si mesmos não são mal-intencionados, apenas reproduzem os preconceitos históricos que temos”, afirma Ana-Andreea Stoica, co-organizadora da iniciativa “Design de mecanismos para o bem-estar social”, um projeto estadunidense que procura aplicar a tecnologia para o bem comum.

“É uma combinação entre ação humana que desenha os algoritmos e a natureza impessoal da tecnologia, que não tem más intenções, mas acaba reproduzindo desigualdades”, diz a jovem pesquisadora da Universidade Columbia.

Daí a importância de prestar atenção especial ao fornecimento de dados. O algoritmo do sistema de saúde estadunidense não foi criado com uma intenção racista, de fato, excluiu dentro de seus parâmetros a raça. No entanto, levou em consideração um parâmetro problemático: gastos com a saúde. Os hospitais gastam 1.800 dólares a menos a cada ano com um paciente negro, em comparação com um paciente branco com o mesmo número de condições crônicas e, portanto, o programa conclui que pacientes negros são mais saudáveis que os brancos.

“O problema não está na tecnologia, o problema é como é treinada. Esta não distingue bairros (como, sim, fazem aqueles que programam os algoritmos que decidem quem pode contrair dívida e quem não)”, diz José Manuel Molina, professor do Departamento de Ciências da Computação da Universidade Carlos III de Madri. Como Stoica, também iniciou um projeto social de educação para a cidadania, juntamente com a Fundação Gregorio Peces-Barba, cujo objetivo é explicar às pessoas como esses vieses funcionam.

O contra-ataque

Existe uma pressão cada vez maior para que as empresas, governos, ONGs e instituições que usam a inteligência artificial ofereçam garantias de que seus sistemas não reproduzem tendências discriminatórias, como evidenciado pelo aumento na criação de princípios e declarações de ética em muitas dessas entidades. Ao mesmo tempo, cada vez mais surgem iniciativas que propõem alternativas para combatê-las.

Para reduzir o preconceito no sistema de saúde estadunidense, é necessário “retreinar” o algoritmo com dados como o número de doenças crônicas e o número de internações hospitalares, em vez de levar em conta os custos de saúde, explica Brian Powers, médico do hospital Brigham and Women's, em Boston, e um dos autores do artigo.

De fato, a equipe de cientistas à qual pertence Powers lançou uma nova iniciativa para trabalhar com centros de saúde e desenvolvedores de algoritmos para reduzir os vieses nos cuidados médicos. Uma abordagem chave é, segundo ele, “o desenvolvimento e implementação de novos rótulos menos propensos aos preconceitos” e alerta que o mesmo deve ser feito em outros setores.

“Se não se reproduz uma realimentação no sistema de aprendizagem da inteligência artificial, esta apenas reproduzirá o que já sabe”, concorda Molina, que acredita que a inteligência artificial não pode trabalhar sozinha. “A inteligência artificial não pode se autorregular porque não sabe o que está errado e o que está certo”, afirma.

No entanto, existe uma nova maneira de ensinar esses algoritmos a não reproduzir “comportamentos indesejáveis”. Uma equipe de cientistas liderada pelas universidades estadunidenses de Stanford e Massachusetts Amherst, juntamente com a Universidade Federal do Rio Grande do Sul, no Brasil, projetou uma técnica, publicada na Science, de aplicação “segura e responsável”, tanto para o usuário (empresas e centros de pesquisa, por exemplo), como para designers.

Esse novo algoritmo, chamado pelos cientistas de “seldoniano” (de Hari Seldon, personagem inventado por Isaac Asimov), é “mais inteligente” e permite ao usuário definir comportamentos indesejados para não os reproduzir. Para fazer isso, precisa “entender” a definição de comportamento indesejável, “raciocinar” sobre o que causa esse comportamento e evitá-lo.

Para atacar os preconceitos de gênero, os pesquisadores testaram esse algoritmo na previsão da nota média dos estudantes universitários com base nos resultados dos testes. Por meio de instruções matemáticas, e graças a um novo filtro de imparcialidade, impediram esse algoritmo de superestimar ou subestimar as qualificações de acordo com o sexo.

“Não estamos propondo algoritmos específicos. Nosso objetivo é propor um novo tipo de algoritmo. Os que criamos são apenas exemplos para mostrar que a criação de algoritmos seldonianos práticos é possível”, diz Philip S. Thomas, principal autor do artigo. Portanto, não há uma maneira fixa de como isso deva funcionar, simplesmente deve possuir garantias de segurança de alta confiabilidade.

Apesar de todas essas iniciativas para combater os preconceitos, os autores do relatório do AI Now Institute advertem que respondem a um problema estrutural, não individual, apontando a “natureza sistêmica do problema”. Assim resume Stoica: “As pessoas são representadas de maneira desigual. Sendo assim, qualquer algoritmo que desenvolverem será desigual”.

Nota de IHU On-Line:

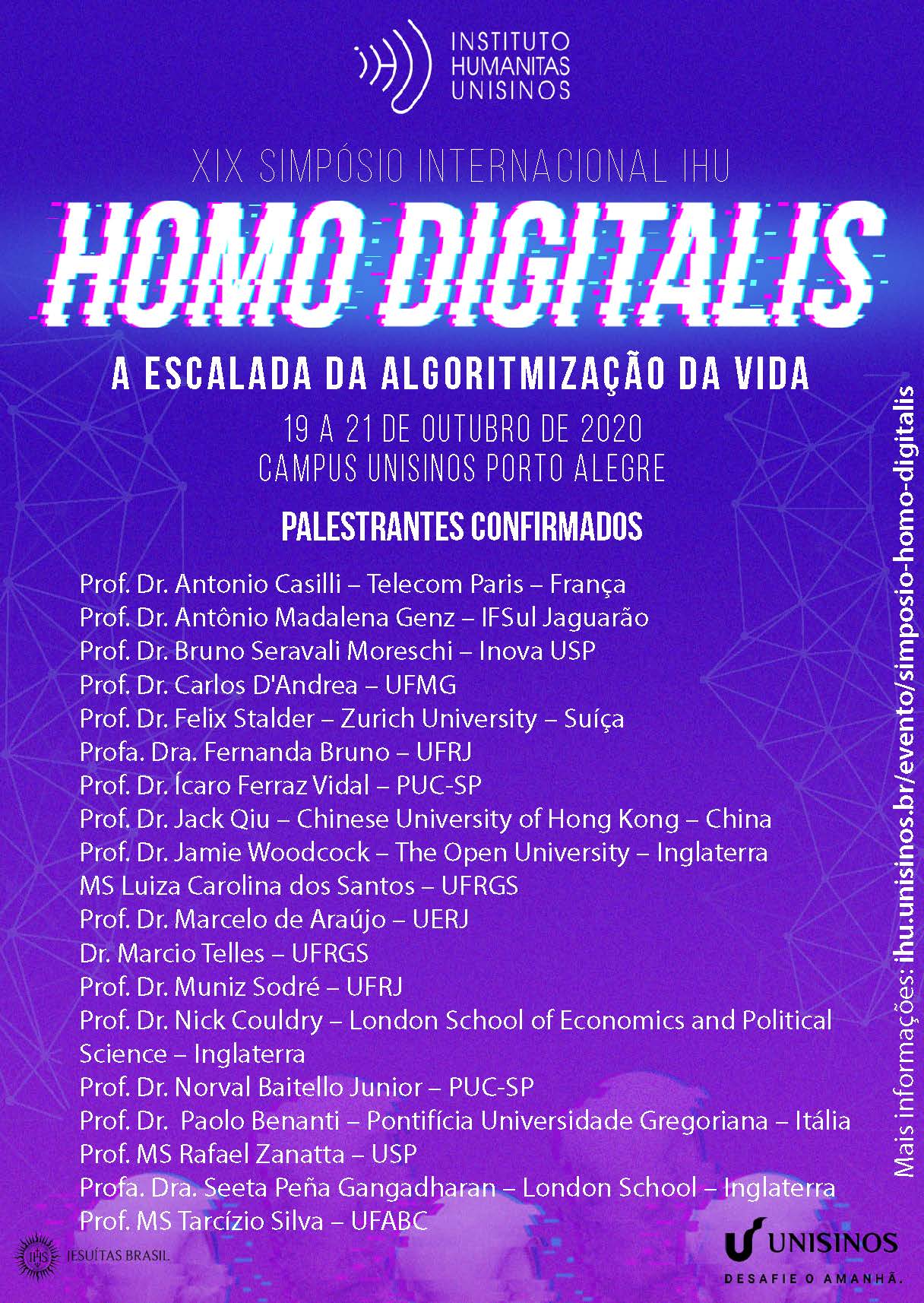

O Instituto Humanitas Unisinos – IHU promove o XIX Simpósio Internacional IHU. Homo Digitalis. A escalada da algoritmização da vida, a ser realizado nos dias 19 a 21 de outubro de 2020, no Campus Unisinos Porto Alegre.

XIX Simpósio Internacional IHU. Homo Digitalis. A escalada da algoritmização da vida.

Leia mais

- Os desafios de uma tecnologia que sirva ao humano e não que se sirva do humano. Revista IHU On-Line, Nº. 544

- Um guia para compreender a quarta Revolução Industrial. Revista IHU On-Line, N° 506

- Homo Deus e a grande revolução algorítmica no século XXI. Revista IHU On-Line, Nº 516

- Na Revolução 4.0, automação ameaçará postos de trabalho mais rapidamente. Entrevista especial com Bruno Ottoni Eloy Vaz

- O fim do indivíduo. Viagem de um filósofo à terra da inteligência artificial

- A mutação do mundo do trabalho e a proteção dos trabalhadores - 60% dos empregos serão automatizados. Entrevista especial com Yuri Lima

- A Revolução 4.0 e a reedição das lógicas das revoluções burguesas. Entrevista especial com Gaudêncio Frigotto

- É importante pensar política industrial e competitividade para o Brasil não perder a revolução 4.0

- Robôs estão entre nós. Como viver num mundo sem empregos para todos?

- Indústria brasileira 2.5. O futuro do Brasil no contexto da Revolução 4.0. Entrevista especial com Fábio do Prado

- Automação vai mudar a carreira de 16 milhões de brasileiros até 2030

- Robótica eliminará até 800 milhões de empregos até 2030

- 50% do trabalho no Brasil pode ser feito por robô, diz estudo

- O impacto da quarta revolução industrial na sociedade

- Quem são os mais propensos a sofrer com a automação do trabalho?

- Tempos de incerteza: um robô poderia substituir meu trabalho?

- 'Profissões deixam de existir, mas surgem outras', diz consultor

- Indústria instala 1,5 mil robôs por ano

- Seremos líderes ou escravos da Indústria 4.0?

- 60% dos jovens estão aprendendo profissões que vão deixar de existir

- A 4.ª revolução industrial e o futuro do emprego

- Futuro do trabalho diante do desmonte do Estado

- O emprego ameaçado por robôs

- A tecnologia que confina o humano. Entrevista especial com Marildo Menegat

- Você corre risco de perder o emprego para um robô?

- Um guia para compreender a quarta Revolução Industrial

- Desculpe, 2020 não indica que será melhor que 2019

- Revolução tecnológica exige novo Estado social, escreve professora

- Os países mais avançados no uso de robôs são os com menor desemprego

- O trabalho do futuro e a alienação do presente

- Robô substitui vaqueiros e faz manejo de gado com sucesso